随机森林算法详解:原理、优缺点及应用

引言

随机森林是机器学习领域中一种强大的集成学习算法,由Leo Breiman在2001年提出。它结合了决策树和bagging技术,通过构建多个决策树并将它们的预测结果进行组合,从而提高了模型的准确性和稳定性。本文将详细介绍随机森林的工作原理、优缺点以及实际应用场景。

随机森林的基本原理

(参考资料:机器学习算法系列(十八)-随机森林算法(Random Forest Algorithm)”)

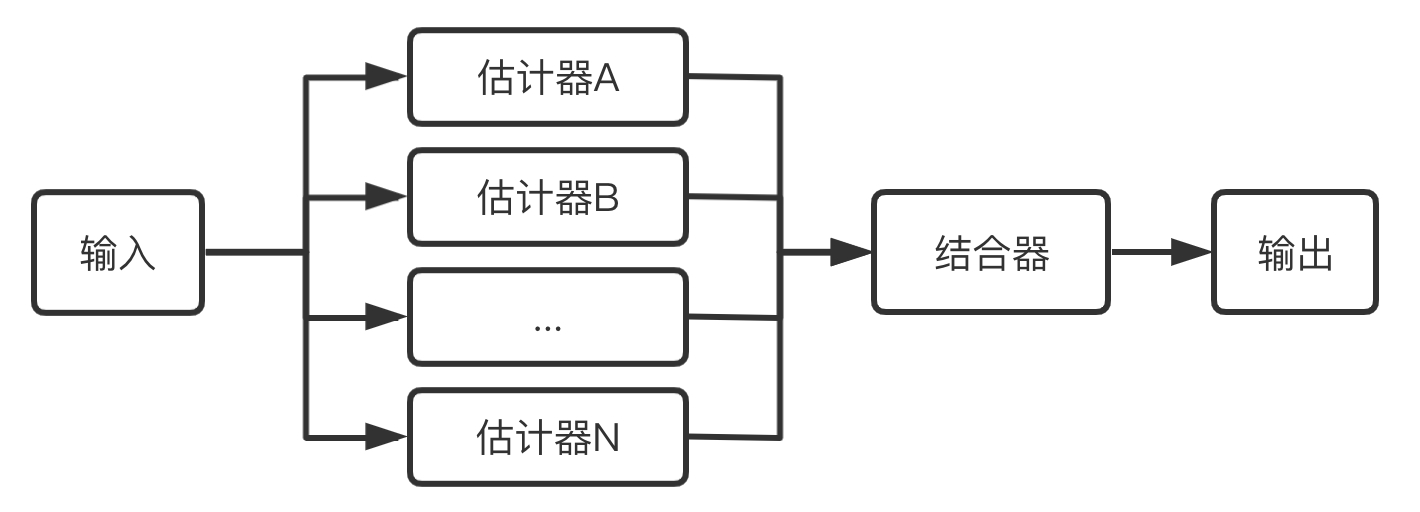

首先介绍机器学习中的一个概念:集成学习(Ensemble learning)。集成学习往往是通过训练学习出多个估计器,当需要预测时通过结合器将多个估计器的结果整合起来当作最后的结果输出。

集成学习的优势是提升了单个估计器的通用性与鲁棒性,比单个估计器拥有更好的预测性能。集成学习的另一个特点是能方便地进行并行化操作。

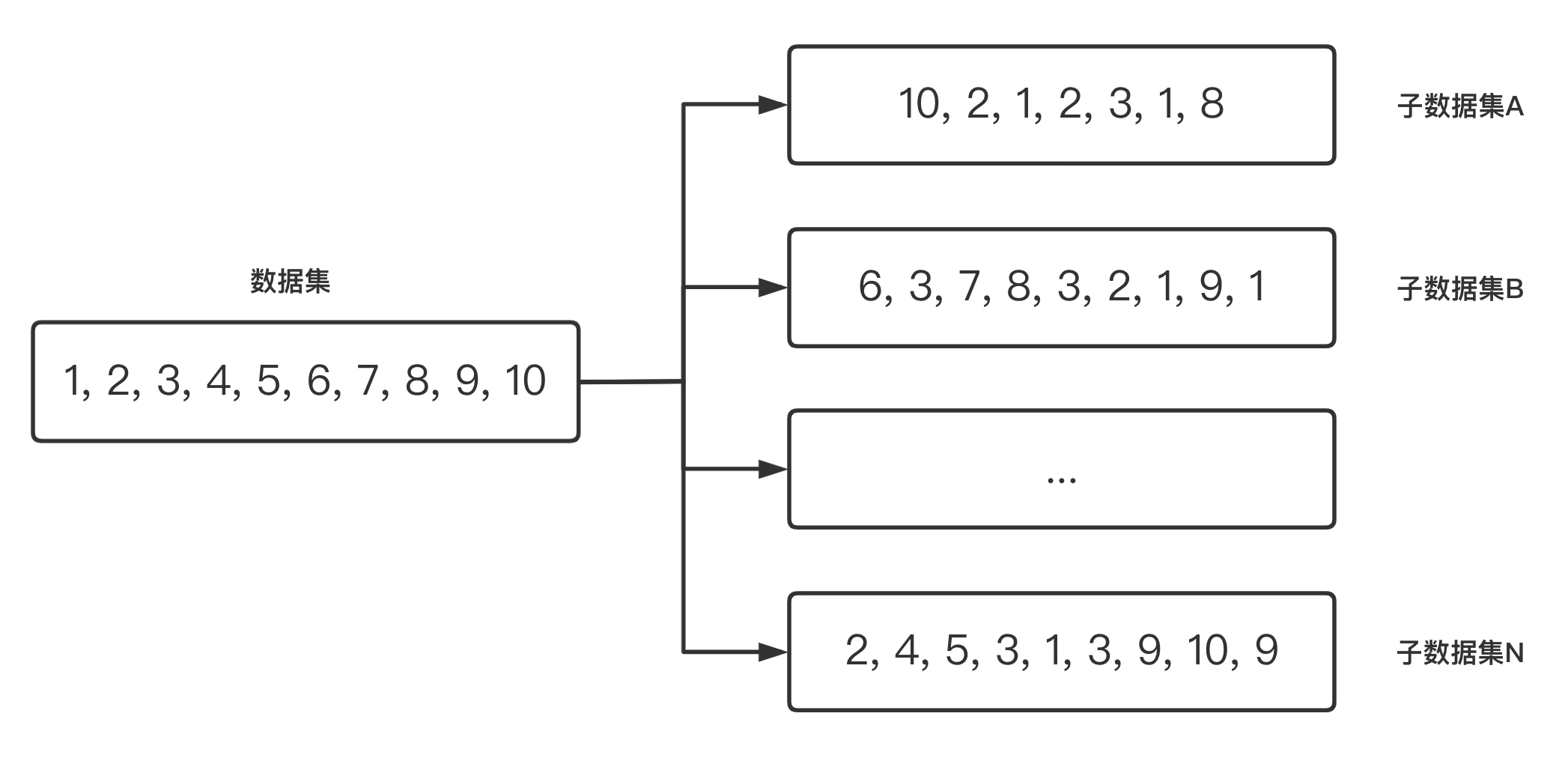

然后在介绍随机森林算法之前,先来介绍一种集成学习算法——Bagging算法,又称自助聚集算法(Bootstrap aggregating),由自助取样(Bootstrap)与汇总(Aggregating)两部分组成。算法的具体步骤为:假设有一个大小为 N 的训练数据集,每次从该数据集中有放回的取选出大小为 M 的子数据集,一共选 K 次,根据这 K 个子数据集,训练学习出 K 个模型。当要预测的时候,使用这 K 个模型进行预测,再通过取平均值或者多数分类的方式,得到最后的预测结果。

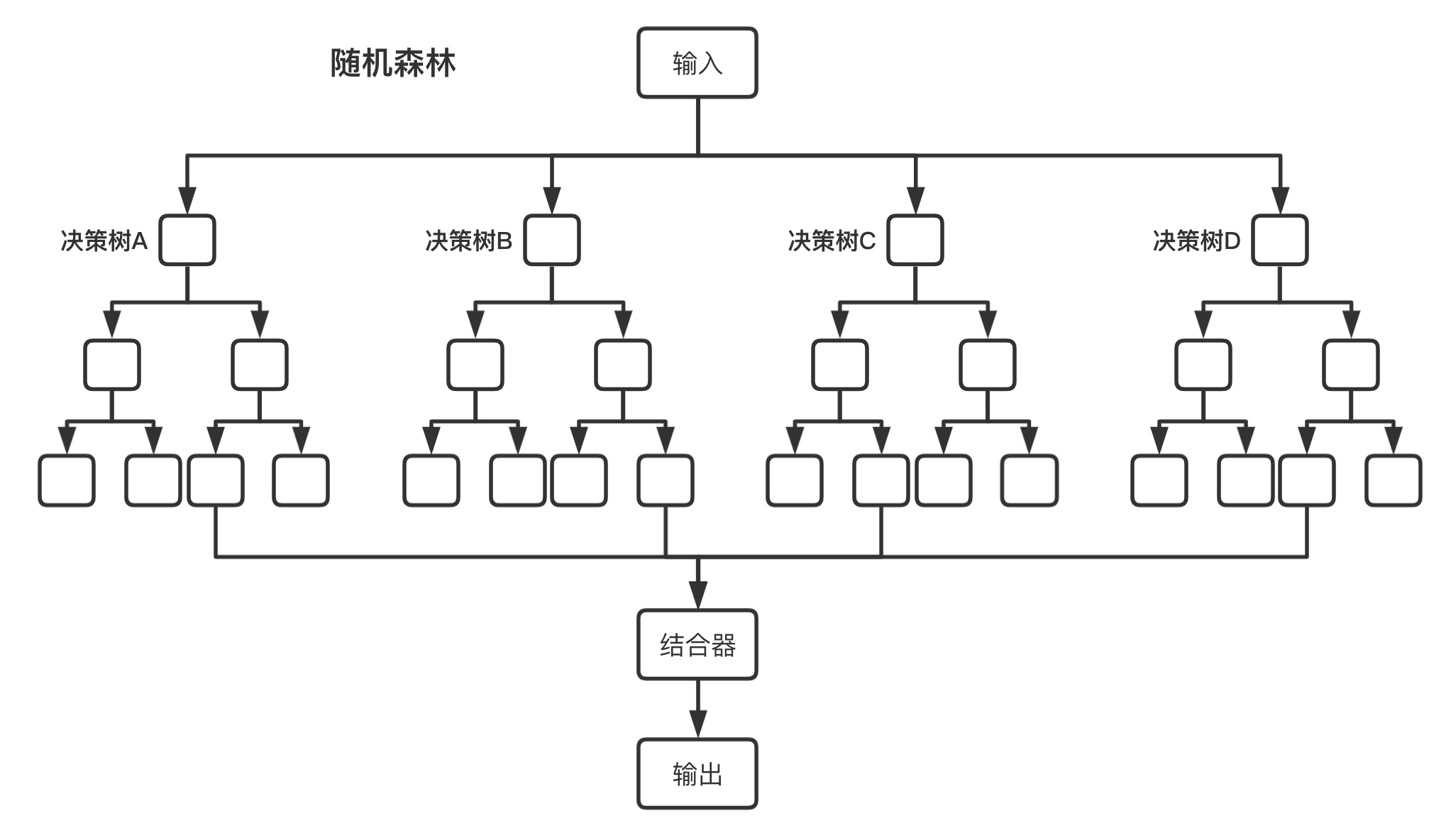

然后来介绍本文的主角——随机森林算法。在上述Bagging算法中,将多个决策树结合在一起,每次数据集是随机有放回的选出,同时随机选出部分特征作为输入,这样的算法即为随机森林算法。随机森林算法是以决策树为估计器的Bagging算法。

随机森林本质上是多个决策树的集合,其中每棵树都是独立训练的。算法的核心思想包括两个随机性:

- 样本随机性:使用bootstrap采样方法从原始训练集中有放回地抽取样本,形成每棵决策树的训练集。

- 特征随机性:在构建每棵决策树的过程中,每次分裂节点时只考虑特征子集(随机选择的特征)。

随机森林算法步骤

- 从原始训练数据集中通过Bootstrap采样选择 n n n个样本

- 对于每个样本集合,构建一个决策树:

- 在节点分裂时,随机选择 m m m个特征, m m m远小于特征总数

- 根据选定的特征,使用信息增益或基尼系数等指标确定最佳分裂点

- 树一直生长到达到停止条件(如叶子节点中的样本数量最小阈值)

- 重复步骤1和2,构建 k k k棵决策树

- 对于分类问题,采用投票方式;对于回归问题,取平均值作为最终预测结果

随机森林的优点

- 高准确性:通过集成多棵决策树的结果,随机森林通常能够获得较高的预测准确率。

- 抗过拟合能力强:随机性的引入有效减少了模型的方差,提高了泛化能力。

- 能处理高维数据:对于特征数量较多的数据集表现良好,无需特征选择。

- 能评估特征重要性:可以计算每个特征对模型预测的贡献度。

- 对缺失值和异常值不敏感:具有较强的鲁棒性。

- 易于并行化:每棵树的训练过程可以独立进行,适合分布式计算。

随机森林的缺点

- 可解释性较差:相比单棵决策树,随机森林的决策过程更难以解释。

- 训练时间较长:需要构建多棵决策树,计算开销较大。

- 对噪声数据敏感:在某些情况下可能会过度拟合噪声。

- 预测时间较长:需要遍历所有决策树才能得出最终结果。

随机森林的应用场景

- 分类与回归问题:适用于各类监督学习任务。

- 特征选择:可以通过特征重要性评分进行特征筛选。

- 异常检测:识别数据集中的异常点。

- 金融领域:风险评估、信用评分、股票预测等。

- 医疗健康:疾病诊断、患者分类等。

- 生物信息学:基因表达分析、蛋白质结构预测等。

- 图像识别:物体检测、人脸识别等。

Python实现示例

下面是使用scikit-learn库实现随机森林的简单示例:

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 生成示例数据

X, y = make_classification(n_samples=1000, n_features=20,

n_informative=15, n_redundant=5,

random_state=42)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y,

test_size=0.2,

random_state=42)

# 创建随机森林分类器

rf_classifier = RandomForestClassifier(n_estimators=100,

max_depth=10,

random_state=42)

# 训练模型

rf_classifier.fit(X_train, y_train)

# 预测

y_pred = rf_classifier.predict(X_test)

# 评估模型

accuracy = accuracy_score(y_test, y_pred)

print(f"模型准确率: {accuracy:.4f}")

# 特征重要性

feature_importances = rf_classifier.feature_importances_

for i, importance in enumerate(feature_importances):

print(f"特征 {i}: {importance:.4f}")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

超参数调优

随机森林的主要超参数包括:

- n_estimators:决策树的数量,一般越多越好,但会增加计算成本。

- max_depth:树的最大深度,控制模型复杂度。

- min_samples_split:分裂内部节点所需的最小样本数。

- min_samples_leaf:叶节点所需的最小样本数。

- max_features:每次分裂时考虑的最大特征数。

可以使用网格搜索或随机搜索等方法进行超参数优化:

from sklearn.model_selection import GridSearchCV

param_grid = {

'n_estimators': [100, 200, 300],

'max_depth': [10, 20, 30, None],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 2, 4]

}

grid_search = GridSearchCV(RandomForestClassifier(random_state=42),

param_grid=param_grid,

cv=5,

n_jobs=-1)

grid_search.fit(X_train, y_train)

print(f"最佳参数: {grid_search.best_params_}")

print(f"最佳得分: {grid_search.best_score_:.4f}")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

结论

随机森林作为一种强大的集成学习方法,在各种机器学习任务中表现出色。它结合了多棵决策树的预测能力,通过引入随机性来提高模型的泛化能力。虽然在可解释性和计算复杂度方面存在一些局限,但其高准确性、抗过拟合能力和处理高维数据的能力使其成为数据科学家和机器学习工程师的重要工具。

随着计算能力的提升和分布式计算技术的发展,随机森林的应用范围将会进一步扩大,尤其是在需要高精度预测且可解释性要求不是特别高的场景中。

参考文献

- Breiman, L. (2001). Random forests. Machine learning, 45(1), 5-32.

- Hastie, T., Tibshirani, R., & Friedman, J. (2009). The elements of statistical learning: data mining, inference, and prediction. Springer Science & Business Media.

- Scikit-learn: Machine Learning in Python, Pedregosa et al., JMLR 12, pp. 2825-2830, 2011.

希望这篇文章能帮助你更好地理解随机森林算法的工作原理、优缺点及应用场景。如有任何问题或建议,欢迎在评论区留言讨论!

评论记录:

回复评论: