在本地成功部署DeepSeek模型后,如何高效调用它发挥其强大功能,以及在不需要时妥善删除,是很多用户关注的重点。我也在后台接到了很多粉丝的留言,询问 DeepSeek 本地部署之后的一些调用和删除的问题,于是我在网上找了现在主流热门的三种本地部署方案,对照他们的部署方式对出了调用和删除的指令,接下来,我们将从不同的部署方式入手,详细介绍对应的调用和删除方法。

当然你如果不了解 DeepSeek,这几篇文章会让你快速领略 DeepSeek 的风采:

热榜好文:

DeepSeek-R1不同版本的 1.5B、7B、8B、14B、32B、70B、671B 主要区别以及各个蒸馏版本的优缺点

实用操作:

如何让DeepSeek成为你的私人客服:DeepSeek接入微信一文全解析

好了话不多说,接下来进入我们今天的主题环节。

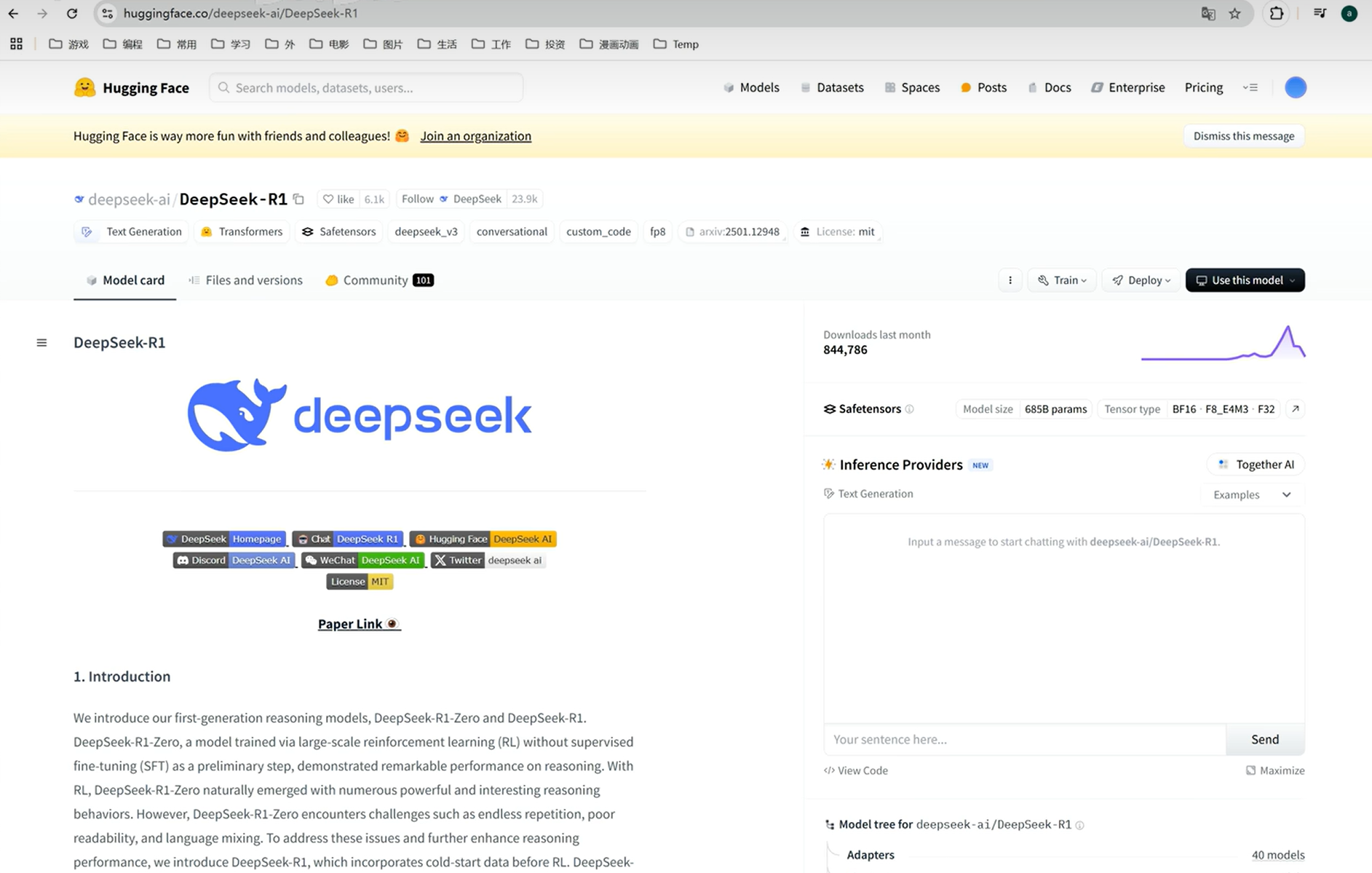

一、基于Hugging Face部署的DeepSeek模型调用与删除

(一)调用方法

-

安装依赖:确保已经安装

transformers库,使用pip install transformers命令完成安装。如果模型运行还依赖其他特定库,如torch等,也需一并安装。 -

代码调用示例:

from transformers import AutoTokenizer, AutoModelForCausalLM

# 加载模型和分词器,替换为实际本地模型路径

tokenizer = AutoTokenizer.from_pretrained("your_local_deepseek_model_path")

model = AutoModelForCausalLM.from_pretrained("your_local_deepseek_model_path")

# 输入文本

input_text = "请描述一下未来城市的样子"

# 对输入文本进行编码

input_ids = tokenizer.encode(input_text, return_tensors='pt')

# 使用模型生成文本

output = model.generate(input_ids, max_length=200, num_beams=5, early_stopping=True)

# 解码生成的文本

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(generated_text)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

在上述代码中,先导入所需类,接着从本地路径加载模型和分词器,然后对输入文本编码,输入模型生成文本,最后解码并输出结果 。

(二)删除方法

-

删除模型文件:定位到本地部署的DeepSeek模型文件夹,直接手动删除整个文件夹。若使用的是Linux系统,可在终端中使用

rm -rf your_local_deepseek_model_path命令删除;Windows系统则直接在文件资源管理器中找到对应文件夹删除。 -

清理缓存和依赖:运行

transformers库提供的清理缓存命令transformers-cli clear -f,清除可能残留的缓存文件。对于不再使用的相关依赖库,使用pip uninstall命令进行卸载,如pip uninstall transformers。

二、通过Ollama部署的DeepSeek模型调用与删除

(一)调用方法

-

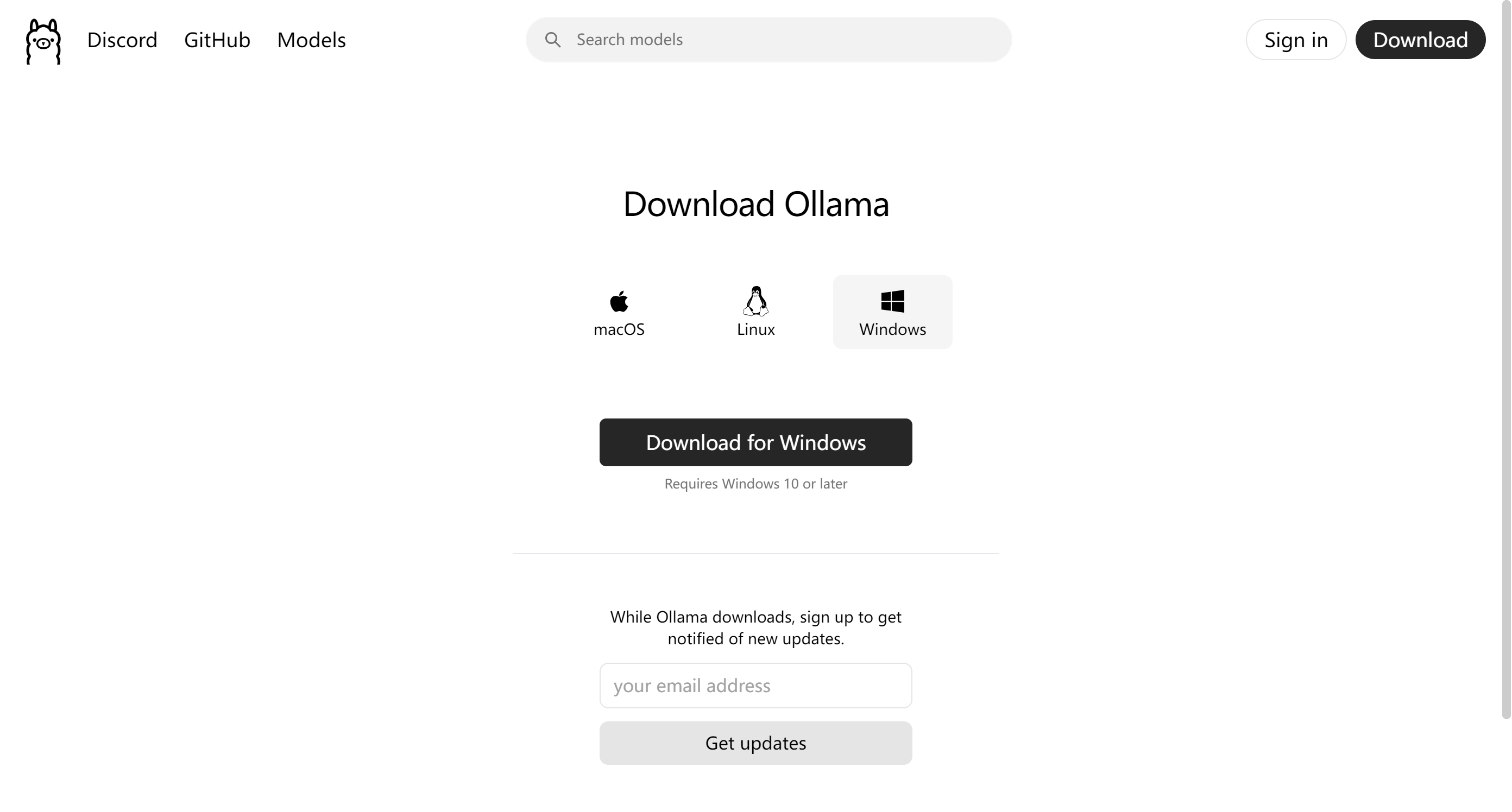

安装Ollama:

-

Linux系统:在终端执行

curl -fsSL https://ollama.com/install.sh | sh命令完成安装。 -

其他系统:可前往Ollama官网(https://ollama.com/),根据对应系统下载安装包进行安装。

-

-

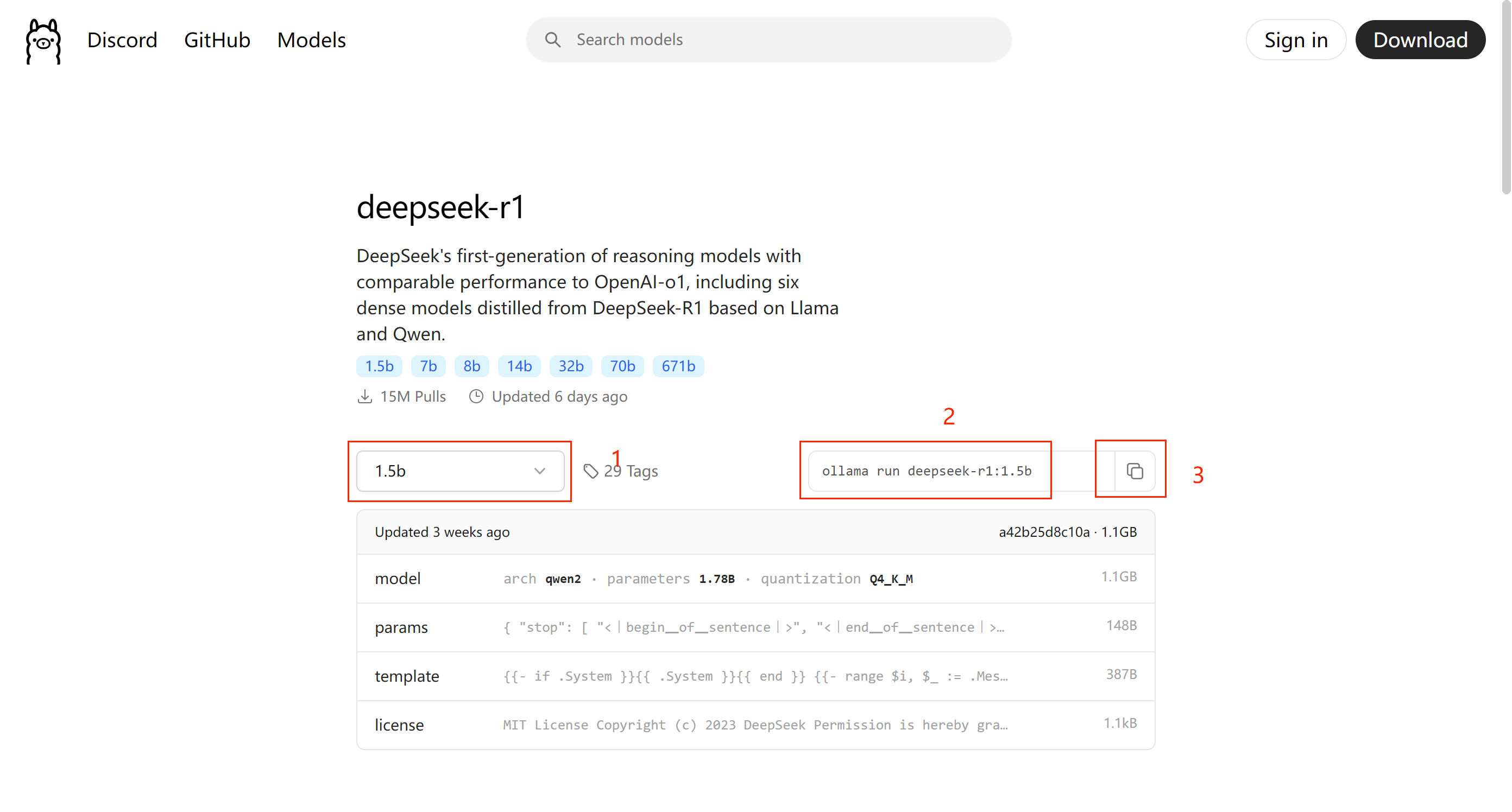

拉取模型:在命令行中输入

ollama run deepseek - r1:1.5b(以deepseek - r1:1.5b模型为例,可根据实际需求替换模型名称和版本),等待模型下载完成。

这里在1的位置可以更换 DeepSeek 的蒸馏模型,更换之后2的位置会出现 DeepSeek 安装指令,最后在3的位置点击复制,打开终端进行安装即可

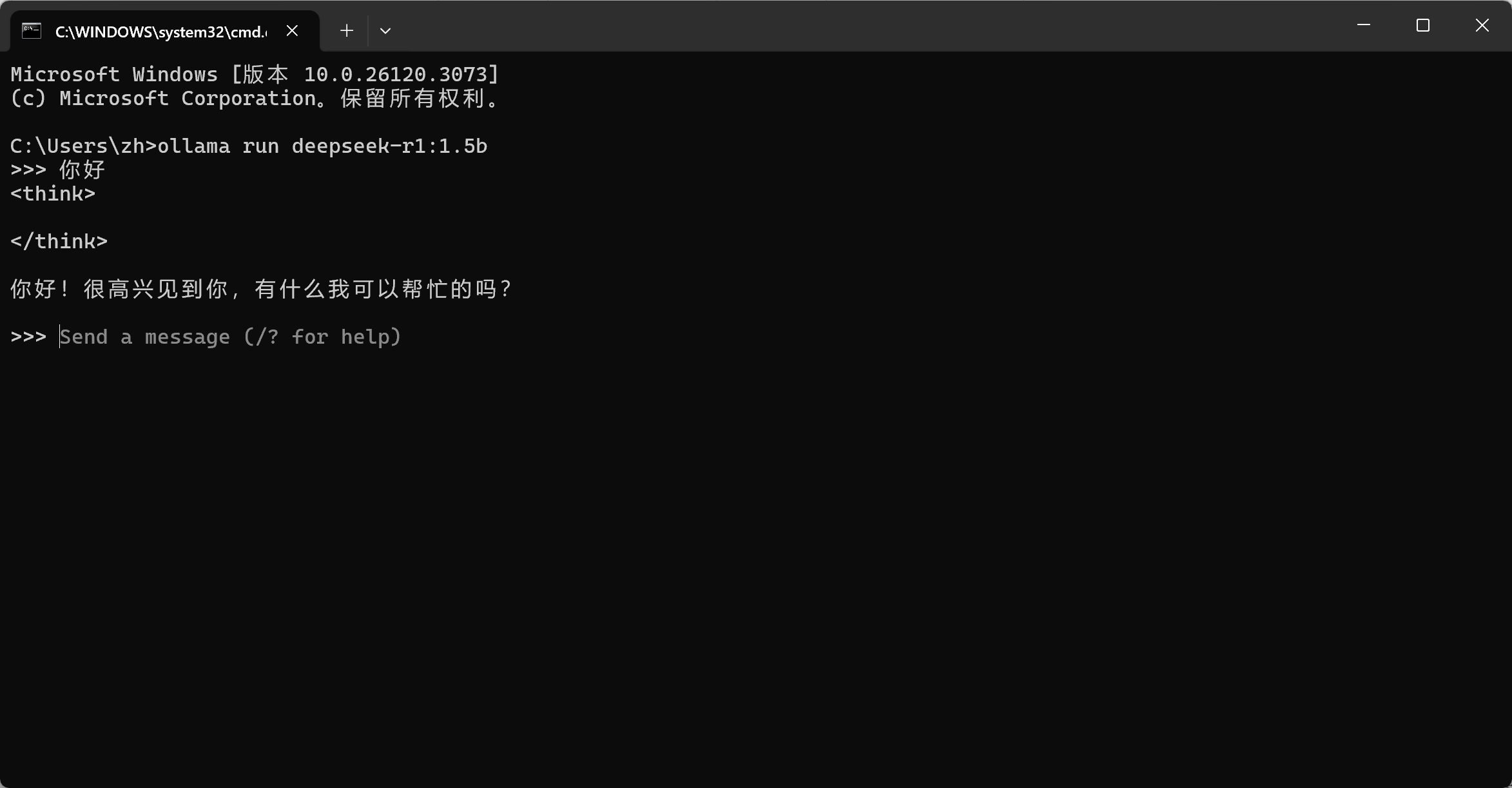

- 运行模型:模型下载完成后,执行

ollama run deepseek - r1:1.5b,在命令行中即可与模型进行交互,输入问题获取回答。

(二)删除方法

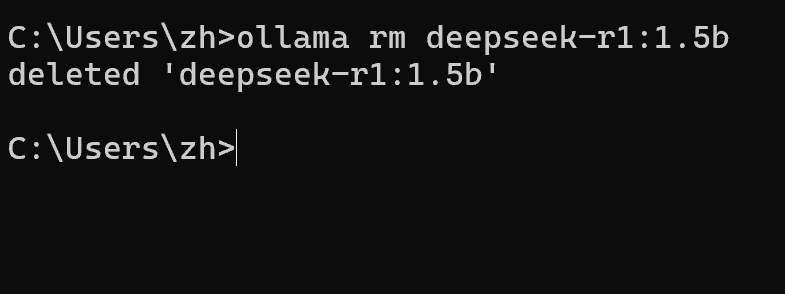

- 删除模型:在命令行中输入

ollama rm deepseek - r1:1.5b,即可删除指定的DeepSeek模型。当然你如果还在模型的交互界面,可以先输入 Ctrl + D 来退出交互模式,ollama rm deepseek - r1:1.5b这条语句是用来删除 deepseek - r1:1.5b 模型的,大家可以根据自己的模型来进行更改。

如果出现下面这条语句,就证明你已经成功删除了ollama rm deepseek - r1:1.5b模型。

- 清理缓存:使用

ollama cache clean命令,清理Ollama运行过程中产生的缓存文件,释放磁盘空间。

三、在Google Colab中部署的DeepSeek模型调用与删除

(一)调用方法

以下是在Hugging Face相关环境下关于DeepSeek模型的调用与删除方法:

调用方法

- 使用transformers库

- 安装依赖:确保已经安装了

transformers库、torch等相关依赖。如果没有,可使用pip install transformers torch进行安装。 - 加载模型:在Python代码中,使用以下方式加载DeepSeek模型。假设要加载

deepseek-coder-1.3b-instruct-function-calling-v2模型,示例代码如下:

- 安装依赖:确保已经安装了

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("Trelis/deepseek-coder-1.3b-instruct-function-calling-v2")

model = AutoModelForCausalLM.from_pretrained("Trelis/deepseek-coder-1.3b-instruct-function-calling-v2")

- 1

- 2

- 3

- 4

- 生成文本:加载完模型和分词器后,就可以进行文本生成等操作,示例代码如下:

input_text = "写一个简单的Python函数"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids, max_length=100)

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(generated_text)

- 1

- 2

- 3

- 4

- 5

-

使用text-generation-inference工具

-

安装部署:按照

text-generation-inference的官方文档进行安装和部署。可以通过pip install text-generation-inference安装,然后根据提示进行配置。 -

启动服务:安装完成后,使用命令

text-generation-server --model-id Trelis/deepseek-coder-1.3b-instruct-function-calling-v2启动服务,这里将Trelis/deepseek-coder-1.3b-instruct-function-calling-v2替换为实际要使用的DeepSeek模型名称即可。 -

发送请求:服务启动后,可以通过HTTP请求来调用模型。示例代码如下:

-

import requests

url = "http://localhost:8080/generate"

data = {"inputs": "请用Java写一个冒泡排序算法"}

response = requests.post(url, json=data)

print(response.json())

- 1

- 2

- 3

- 4

- 5

- 6

删除方法

- 通过Hugging Face Hub删除

-

登录账号:在Hugging Face官网登录自己的账号。

-

Hugging Face官网:https://huggingface.co/

-

找到模型:进入自己的模型仓库,找到要删除的DeepSeek模型对应的项目。

-

删除操作:点击模型项目页面中的相关删除按钮或选项,按照提示确认删除操作。

-

- 通过本地缓存删除

- 找到缓存路径:Hugging Face模型的缓存路径通常在

~/.cache/huggingface/hub目录下。如果是Windows系统,一般在C:\Users\[用户名]\.cache\huggingface\hub。 - 删除模型文件:进入对应的模型缓存目录,删除与要删除的DeepSeek模型相关的所有文件和文件夹。

- 找到缓存路径:Hugging Face模型的缓存路径通常在

无论采用哪种方式本地部署DeepSeek模型,在调用时都要确保环境配置正确,在删除时要谨慎操作,避免误删重要文件,确保系统资源的合理管理和使用 。

评论记录:

回复评论: