1.DeepSeek 在 LLM 推理上的创新方法

DeepSeek 在最新论文中详细介绍了他们通过强化学习(RL)提升大语言模型(LLM)推理能力的创新方法——DeepSeek-R1。这项研究标志着一个重要的进展,即如何通过纯强化学习提升 LLM 解决复杂问题的能力,而不依赖于大量的监督微调。

2.DeepSeek-R1 的技术概述

2.1 模型架构

DeepSeek-R1 不是单一的模型,而是一个模型家族,包括:

-

DeepSeek-R1-Zero

-

DeepSeek-R1

2.2 主要区别

-

DeepSeek-R1-Zero 是团队最初的实验,完全基于强化学习,没有进行任何监督微调。他们从基础模型出发,直接应用强化学习,让模型通过试错过程自行发展推理能力。这种方法在 AIME 2024 竞赛中达到了 71% 的准确率,展现出了一定的推理能力,但存在可读性和语言一致性上的限制。该模型采用 6710 亿参数,使用 Mixture-of-Experts (MoE) 架构,每个 token 仅激活 370 亿参数,展现出了诸如 自我验证、反思、长链推理(CoT) 等涌现能力。

-

DeepSeek-R1 采用了更复杂的多阶段训练方法。它并非纯强化学习,而是在强化学习前,首先进行 监督微调(使用精心挑选的“冷启动数据”),然后再应用强化学习。这种方法解决了 DeepSeek-R1-Zero 的局限性,同时实现了更高的性能。该模型仍然是 6710 亿参数,但在可读性和连贯性上有明显提升。

3. 训练方法对比

3.1 训练方法

-

强化学习(RL): DeepSeek-R1 主要依赖强化学习,而不是传统的监督学习。训练过程中使用 群体相对策略优化(GRPO),结合准确性和格式奖励来增强推理能力,而无需大量标注数据。

-

蒸馏技术: DeepSeek 还发布了从 1.5B 到 70B 参数的蒸馏版本,这些模型基于 Qwen 和 Llama 架构,证明了复杂推理能力可以被压缩进更小、更高效的模型。蒸馏过程使用 DeepSeek-R1 生成的合成推理数据进行微调,从而在降低计算成本的同时保持高性能。

3.2 训练流程对比

3.2.1 DeepSeek-R1-Zero 训练流程

-

从基础模型开始

-

直接应用强化学习

-

使用简单的准确性和格式奖励

3.2.2 DeepSeek-R1 训练流程

-

先进行数千条高质量示例的监督微调

-

强化学习,专注于推理任务

-

通过拒绝采样收集新的训练数据

-

进行最终的强化学习,涵盖所有任务

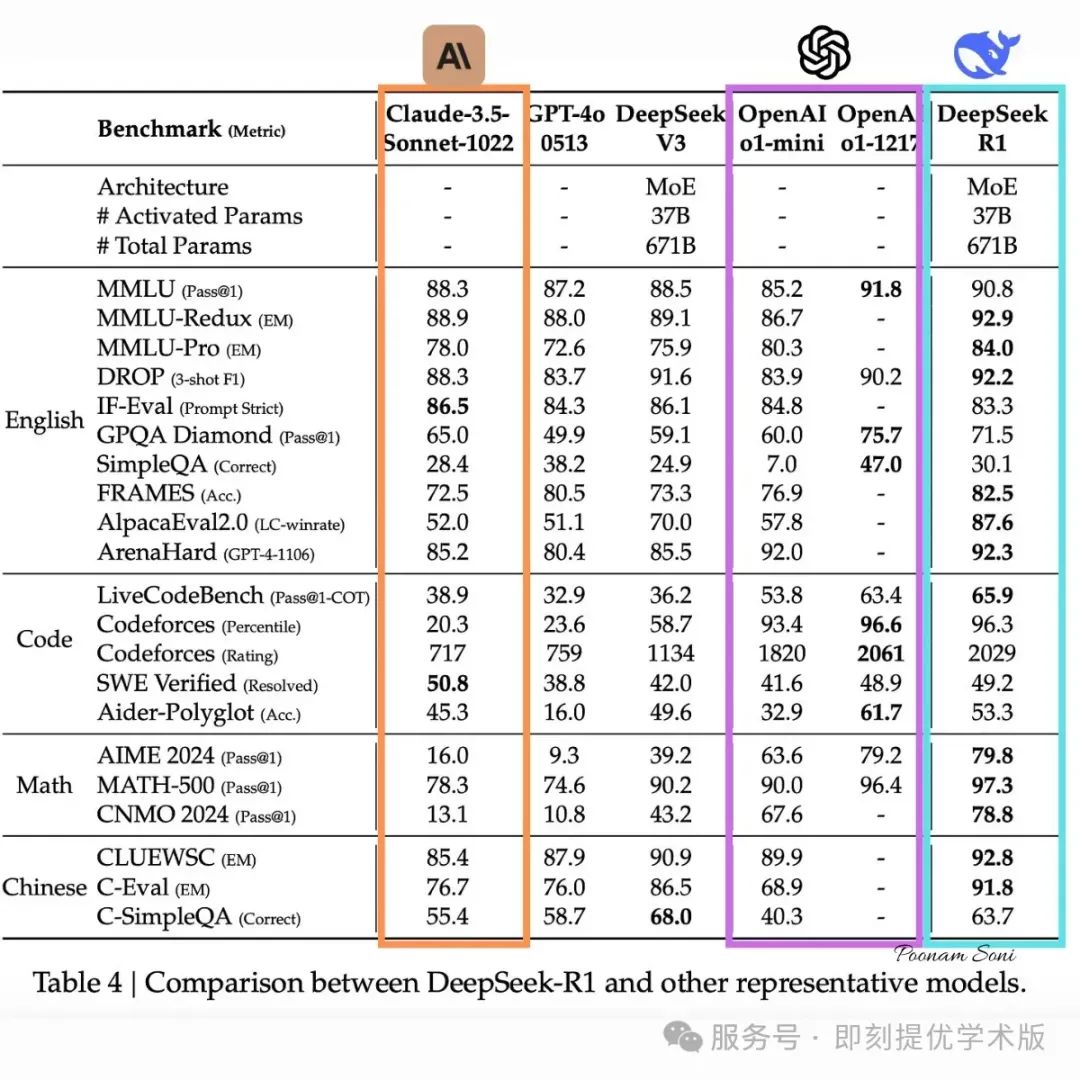

3.3 性能指标

3.3.1 推理基准测试

DeepSeek-R1 在多个基准测试中表现出色:

-

AIME 2024: 通过率 79.8%,略高于 OpenAI 的 o1–1217(79.2%)

-

MATH-500: 得分 97.3%,领先于 o1–1217 的 96.4%

-

SWE-bench Verified: 在编程任务上表现优异,展示了其代码推理能力

3.3.2 成本优势

DeepSeek-R1 API 价格为 每百万输入 token $0.14(缓存命中情况下),远低于 OpenAI 的 o1 模型。

3.4 局限性与未来方向

论文提到了几个待改进的领域:

-

处理特定格式输出的能力仍需优化

-

软件工程任务上的表现可进一步提升

-

在多语言环境下的语言混合问题仍待解决

-

Few-shot 提示词(Few-shot Prompting)会导致性能下降

未来研究方向包括 函数调用、多轮对话、复杂角色扮演 等新能力的扩展。

4. 部署与获取方式

4.1 开源与许可

DeepSeek-R1 及其变体均以 MIT 许可证 公开,支持开源合作和商业用途,包括模型蒸馏。这一举措有助于推动创新,降低 AI 模型开发的门槛。

4.2 模型格式

模型及其蒸馏版本支持 GGML、GGUF、GPTQ、HF 等格式,适用于不同的本地部署需求。

4.3 获取方式

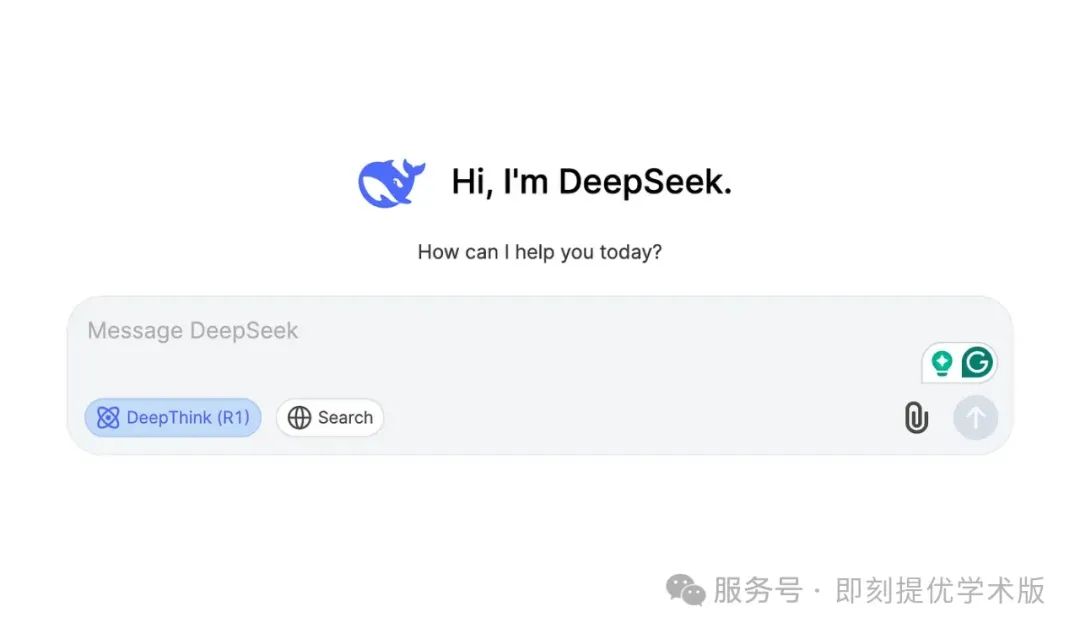

1. 通过 DeepSeek Chat 平台

DeepSeek Chat 提供 无需配置 的交互界面,可直接体验 DeepSeek-R1 的推理能力。

使用步骤:

-

访问 DeepSeek Chat 平台

-

注册或登录账户

-

选择 “Deep Think” 模式,体验 DeepSeek-R1 的逐步推理能力

2. 通过 DeepSeek API

DeepSeek 提供与 OpenAI 兼容的 API,可轻松集成到各种应用中。

使用步骤:

a. 获取 API Key

-

访问 DeepSeek API 平台,注册并生成 API Key

b. 配置环境

-

设置

base_url为https://api.deepseek.com/v1 -

在 HTTP 头部使用 API Key 进行身份验证

c. 调用 API

-

发送请求到 API,获取 DeepSeek-R1 生成的响应

-

详细文档可在 DeepSeek API Docs 中查看

5. 本地部署 DeepSeek-R1

5.1 完整模型(R1 和 R1-Zero)

硬件需求:

-

GPU: 建议使用 Nvidia RTX 3090 或更高,以提供流畅的运行体验

-

CPU: 至少 48GB RAM 和 250GB 硬盘空间(但无 GPU 加速时性能较慢)

5.2 蒸馏模型(适合低配设备)

-

7B 参数模型 适用于 6GB VRAM GPU 或 4GB RAM CPU(使用 GGML/GGUF 格式)

6. 本地运行工具

-

Ollama(推荐):用于本地运行 AI 模型

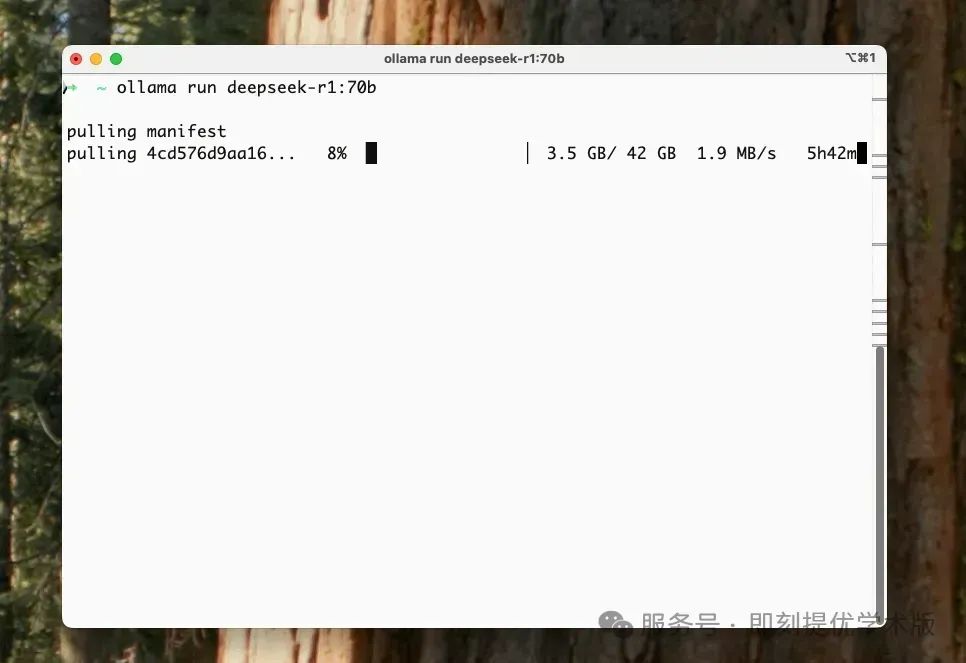

接下来,需要在本地提取并运行 DeepSeek R1 模型。

Ollama 提供不同尺寸的模型 — 基本上,更大的模型等于更智能的 AI,但需要更好的 GPU。以下是阵容:

1.5B 版本(最小): ollama run deepseek-r1:1.5b 8B 版本: ollama run deepseek-r1:8b 14B 版本: ollama run deepseek-r1:14b 32B 版本: ollama run deepseek-r1:32b 70B 版本(最大/最智能): ollama run deepseek-r1:70b

要开始尝试 DeepSeek-R1,建议从较小的模型开始,以熟悉设置并确保与硬件的兼容性。我们可以通过打开终端并执行以下命令来启动此过程:

ollama 运行 deepseek-r1:8b

通过 Ollama 向本地下载的 DeepSeek-R1 发送请求:

Ollama 提供了一个 API 端点,用于以编程方式与 DeepSeek-R1 进行交互。在发出 API 请求之前,请确保 Ollama 服务器在本地运行。我们可以通过运行以下命令来启动服务器:

ollama serve

一旦服务器处于活动状态,就可以使用curl以下命令发送请求:

curl -X POST http://localhost:11434/api/generate -d '{

"model": "deepseek-r1",

"prompt": "您的问题或提示在此"

}'

将其替换"Your question or prompt here"为向模型提供的实际输入。此命令向本地 Ollama 服务器发送 POST 请求,该服务器使用指定的 DeepSeek-R1 模型处理提示并返回生成的响应。

-

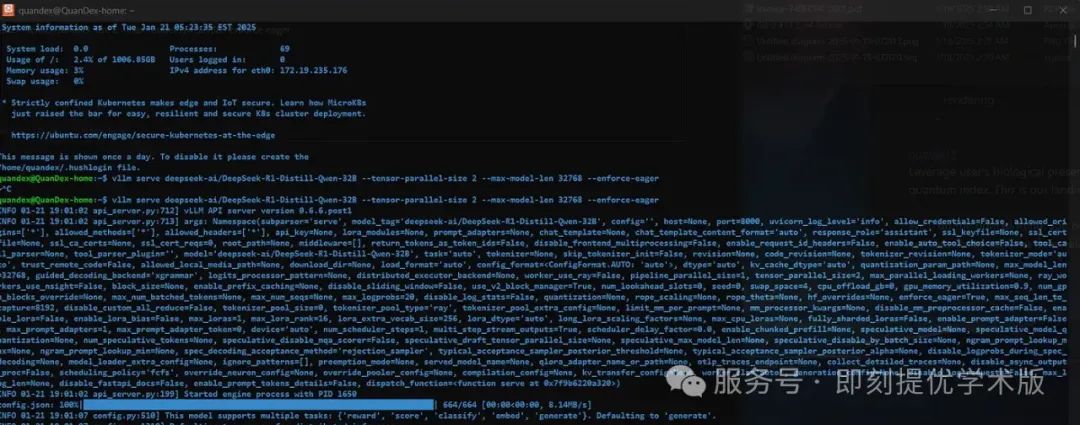

vLLM/SGLang:可用于本地推理,例如:

用于在本地提供模型。vllm serve deepseek-ai/DeepSeek-R1-Distill-Qwen-32B — tensor-parallel-size 2 — max-model-len 32768 — force-eager 等命令可用于精简版本。

-

llama.cpp:另一个适用于本地部署的工具

7. 社区案例

以下是一些开发者使用 DeepSeek-R1 的案例:

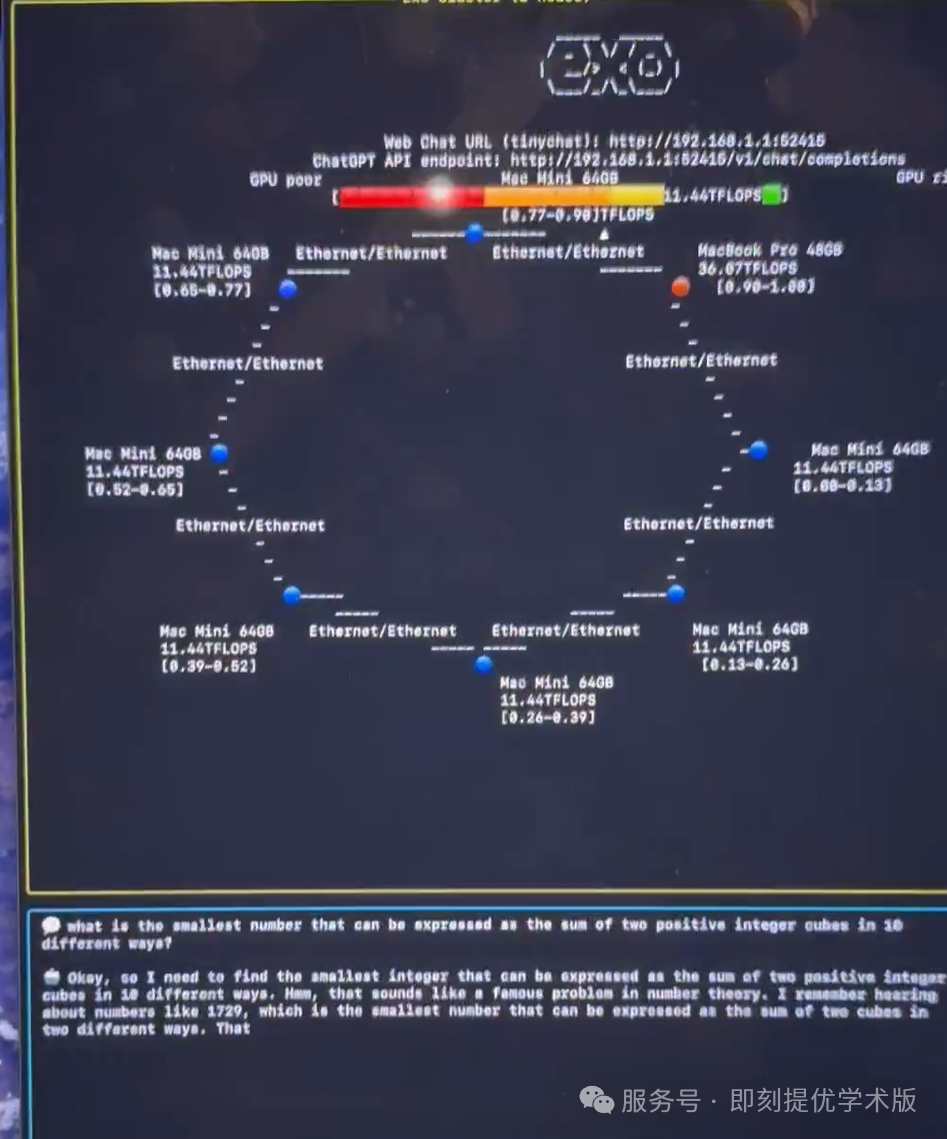

✅ 在 7 台 M4 Pro Mac Mini 和 1 台 M4 Max MacBook Pro 上运行 DeepSeek-R1

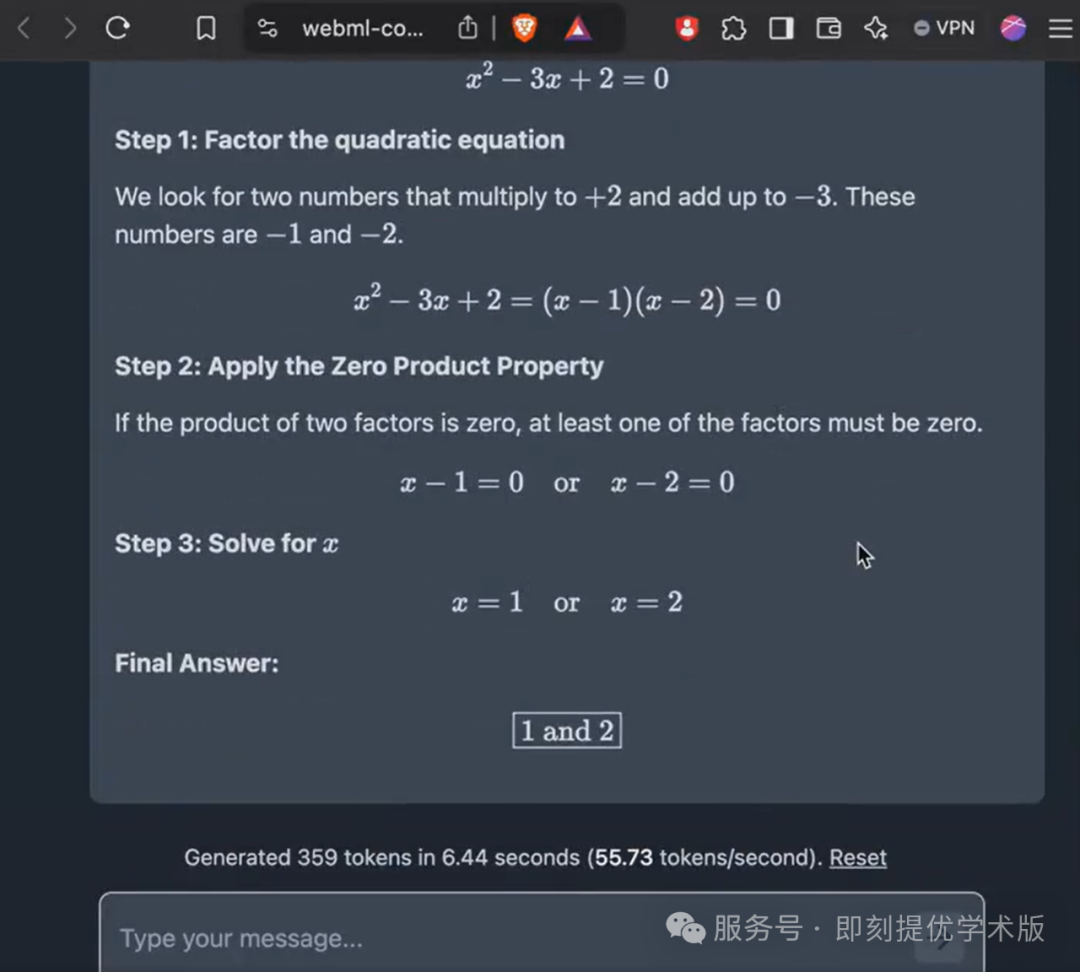

✅ DeepSeek-R1 1.5B 在浏览器中本地运行,速度达 60 token/s(基于 WebGPU)

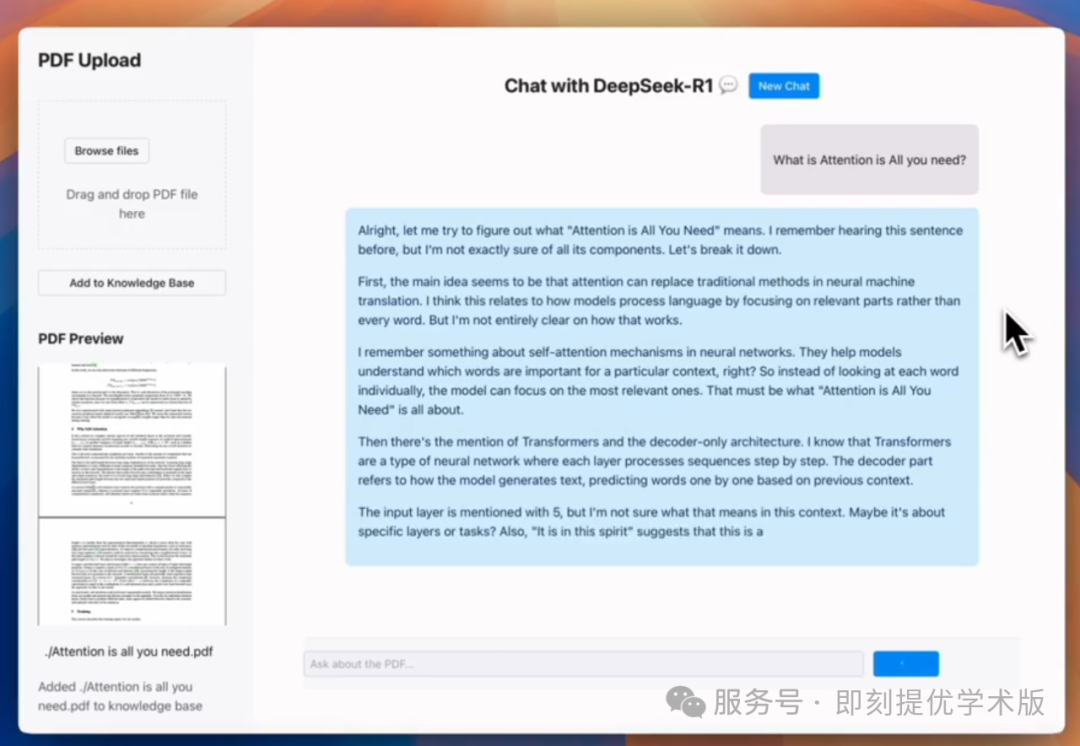

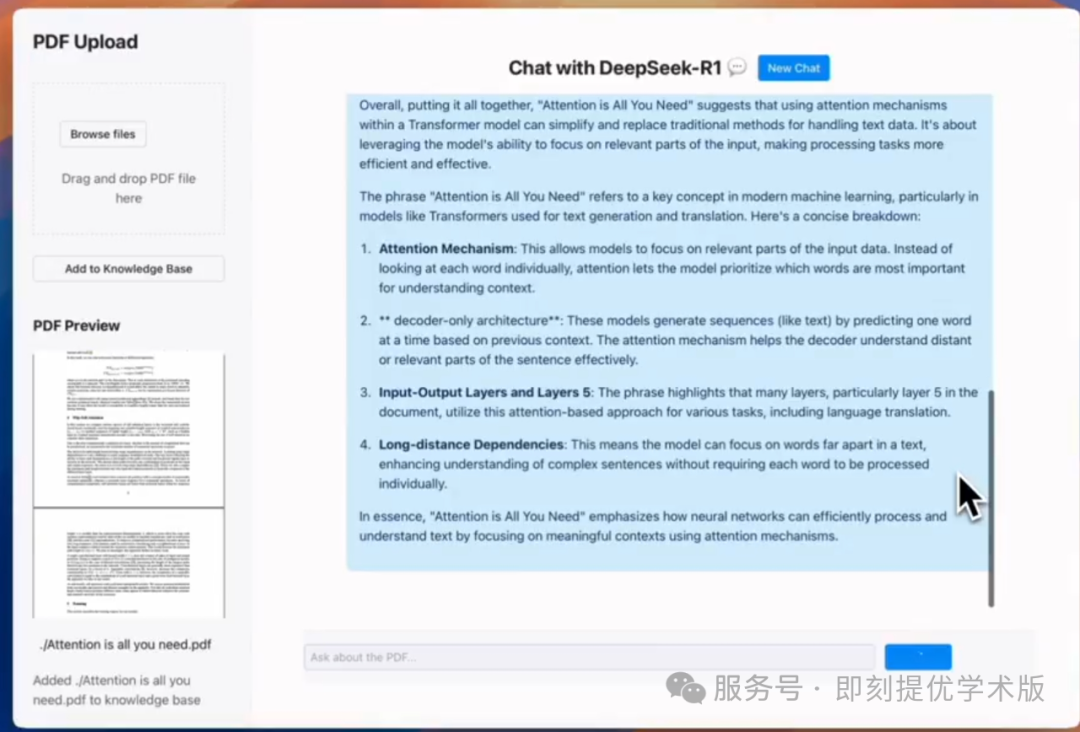

✅ 本地 RAG 应用:使用 DeepSeek-R1 进行 PDF 文档交互

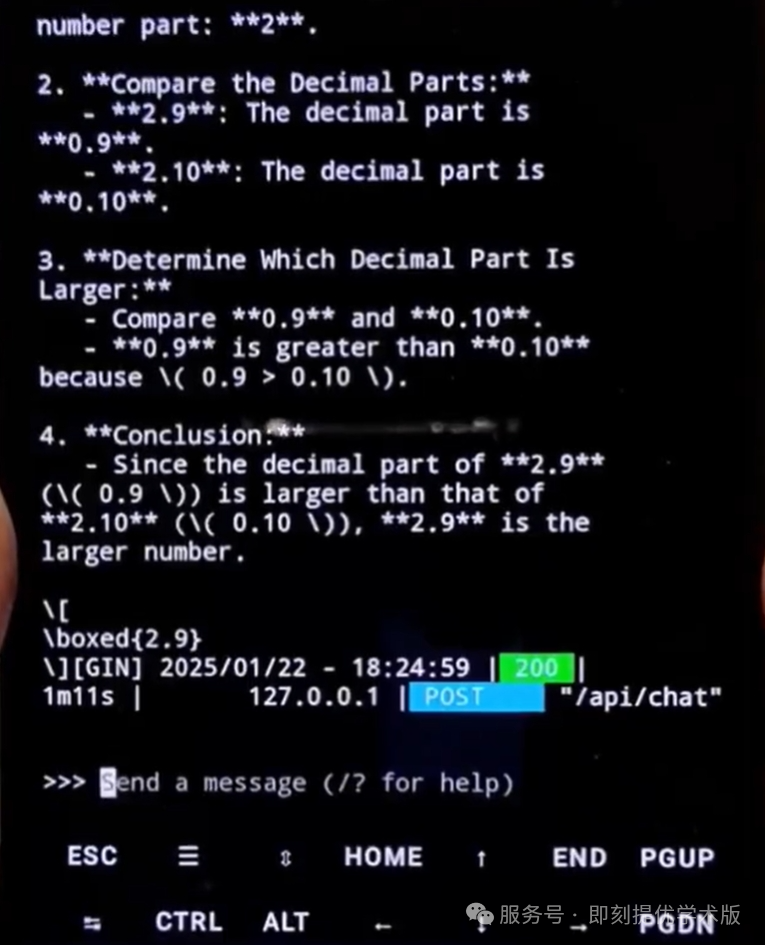

✅ 在手机上完美运行 DeepSeek-R1 1.5B 版本

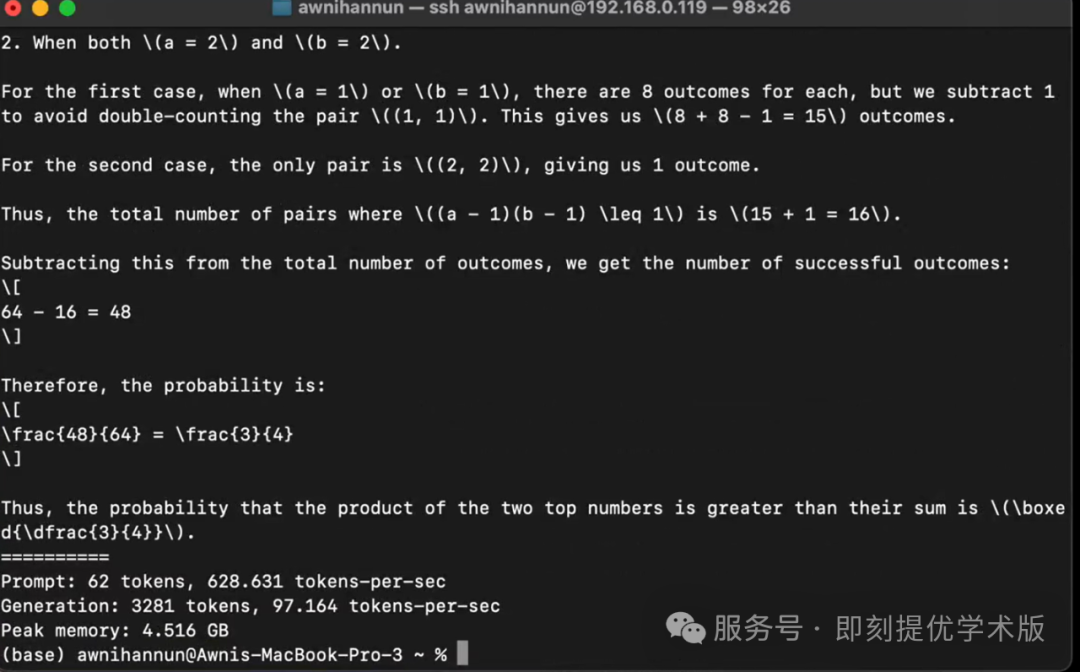

✅ 轻松破解复杂数学问题!(在 M4 Max 上推理 3200 个 token 仅需 35 秒)

8. 总结

从 DeepSeek-R1-Zero 到 DeepSeek-R1,团队经历了一次重要的学习过程。DeepSeek-R1-Zero 证明了 纯强化学习 可以奏效,而 DeepSeek-R1 进一步展示了 监督学习+强化学习 结合的优势,使模型更加强大和实用。

9. 合作机会 ?

如果你对 AI 研究感兴趣,欢迎关注我一起探索更多可能性!

评论记录:

回复评论: