春节期间,DeepSeek大出圈,试过本地SD的我也尝试着做了一下本地部署,没想到,太简单了,几乎不需要做任何处理!

电脑:Notebook,Intel集成显卡

环境:Windows11

准备:安装python 3.10以上版本,我的电脑里有3.10.11,略过此步骤。

一,下载Ollama并安装运行DeepSeek

1,从Ollama官方网站下载Ollama:

https://ollama.com/

Ollama的官方网站的安装包也在Github上,下载速度很慢。我这里大约150kB/s。

可以从https://ollama.zhike.in/下载,使用github加速,链接如下(745M版本):

https://ghfast.top/https://github.com/ollama/ollama/releases/download/v0.5.7/OllamaSetup.exe

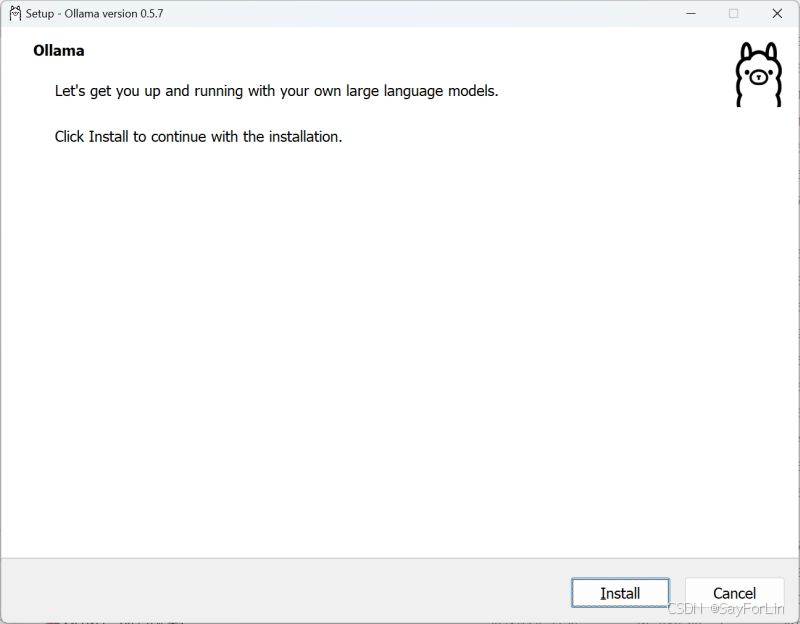

2,安装Ollama

1) 如果在windows下打开运行,会自动安装到C盘:( 不想定制化可略过以下步骤。

- 2) 要将 Ollama 应用程序安装在不同于用户目录的位置,需要使用命令行,例如在cmd或powershell里带参数安装。

- OllamaSetup.exe /DIR="d:\DeepSeek"

- 3) 更改模型存储位置(第一步指定了安装路径,则该步骤是可选的)

- 要更改 Ollama 存储下载模型的位置,而不是使用你的主目录,可以在你的用户账户中设置环境变量 OLLAMA_MODELS。

- 启动设置(Windows 11)或控制面板(Windows 10)应用程序,并搜索"环境变量"。

- 点击"编辑账户环境变量",编辑或创建一个新的用户账户变量 OLLAMA_MODELS,设置为你希望存储模型的路径。

- 如果 Ollama 已经在运行,请退出系统托盘中的应用程序,然后从开始菜单或在保存环境变量后启动的新终端中重新启动它

- 4) 故障排除

- Ollama 在 Windows 上将文件存储在几个不同的位置。你可以在资源管理器窗口中通过按下 <cmd>+R 并输入以下内容来查看:

- explorer %LOCALAPPDATA%\Ollama 包含日志和下载的更新

- app.log 包含 GUI 应用程序的最新日志

- server.log 包含服务器的最新日志

- upgrade.log 包含升级的日志输出

- explorer %LOCALAPPDATA%\Programs\Ollama 包含二进制文件(安装程序会将其添加到你的用户 PATH 中)

- explorer %HOMEPATH%\.ollama 包含模型和配置

- explorer %TEMP% 包含临时可执行文件,位于一个或多个 ollama* 目录中

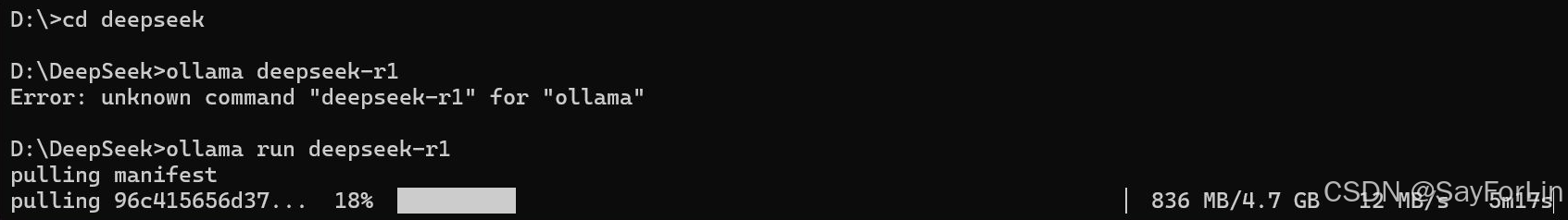

3,下载模型并运行(以后也使用同样的命令启动)

DeepSeek-R1有多个模型可选:

最轻量的是1.5b,即15亿参数,约1.1G,是DeepSeek训练的基础模型。

然后是7b,属于QWen蒸馏,大约4.7G。

再之后是8b,属于llama蒸馏,大约4.9G,从测试得分看,还不如7b,所以是我的首选。

再往下的14b-671b就不太适合在笔记本上部署了。

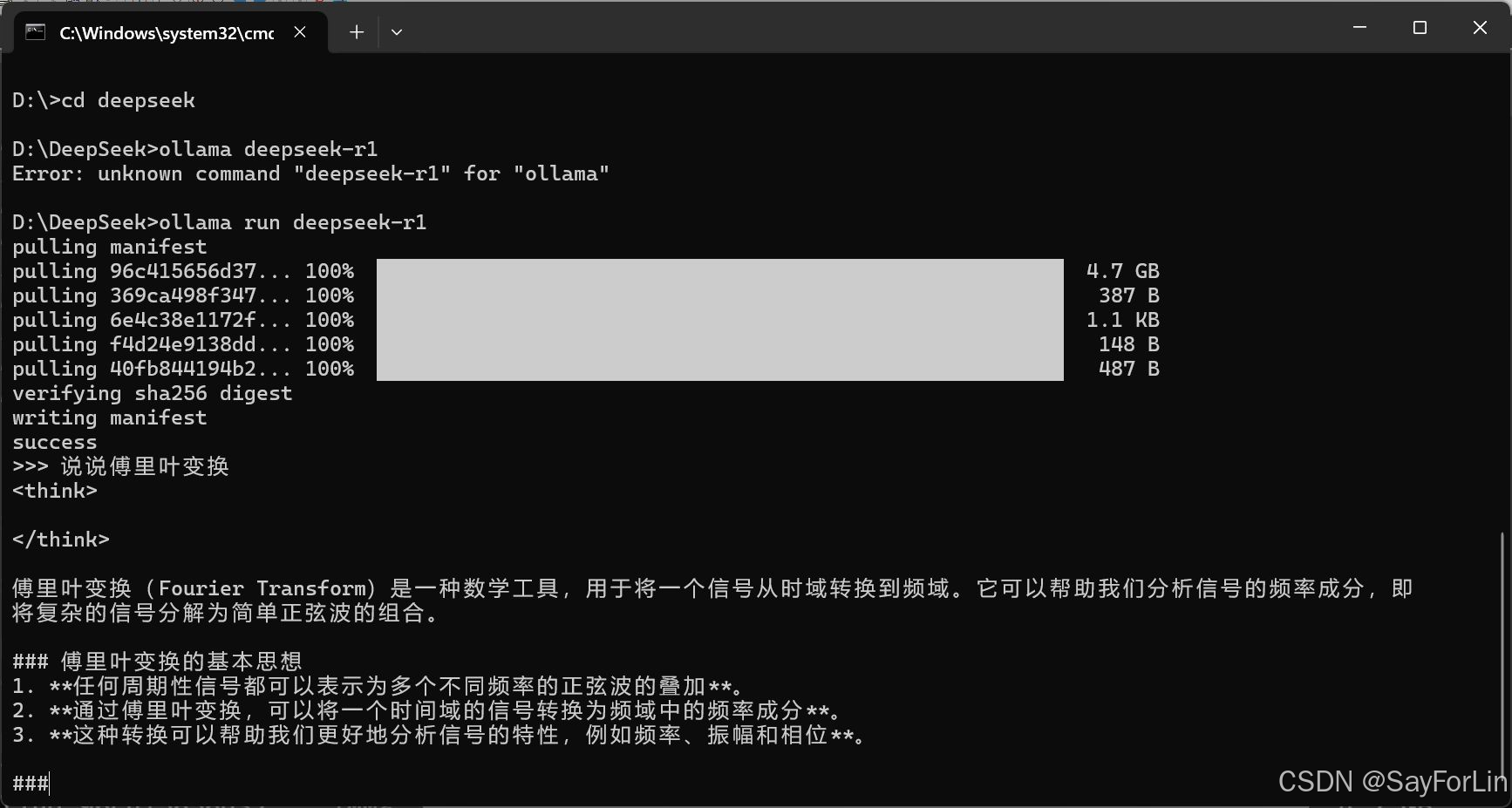

直接运行ollama即可下载,7b也是下载的默认选项:

D:\DeepSeek>ollama run deepseek-r1

或指定:

D:\DeepSeek>ollama run deepseek-r1:7b

速度很快,我怀疑是因为我的python配置了Pypi的阿里云国内镜像。

下载的模型,会保存到C:\Users\username\.ollama\models\blobs

自动完成后,出现>>>提示符,就可以提问题了。

但是在cmd窗口不方便,也不美观,我们需要安装一个对话界面来提高使用便利性。

二,安装前端界面

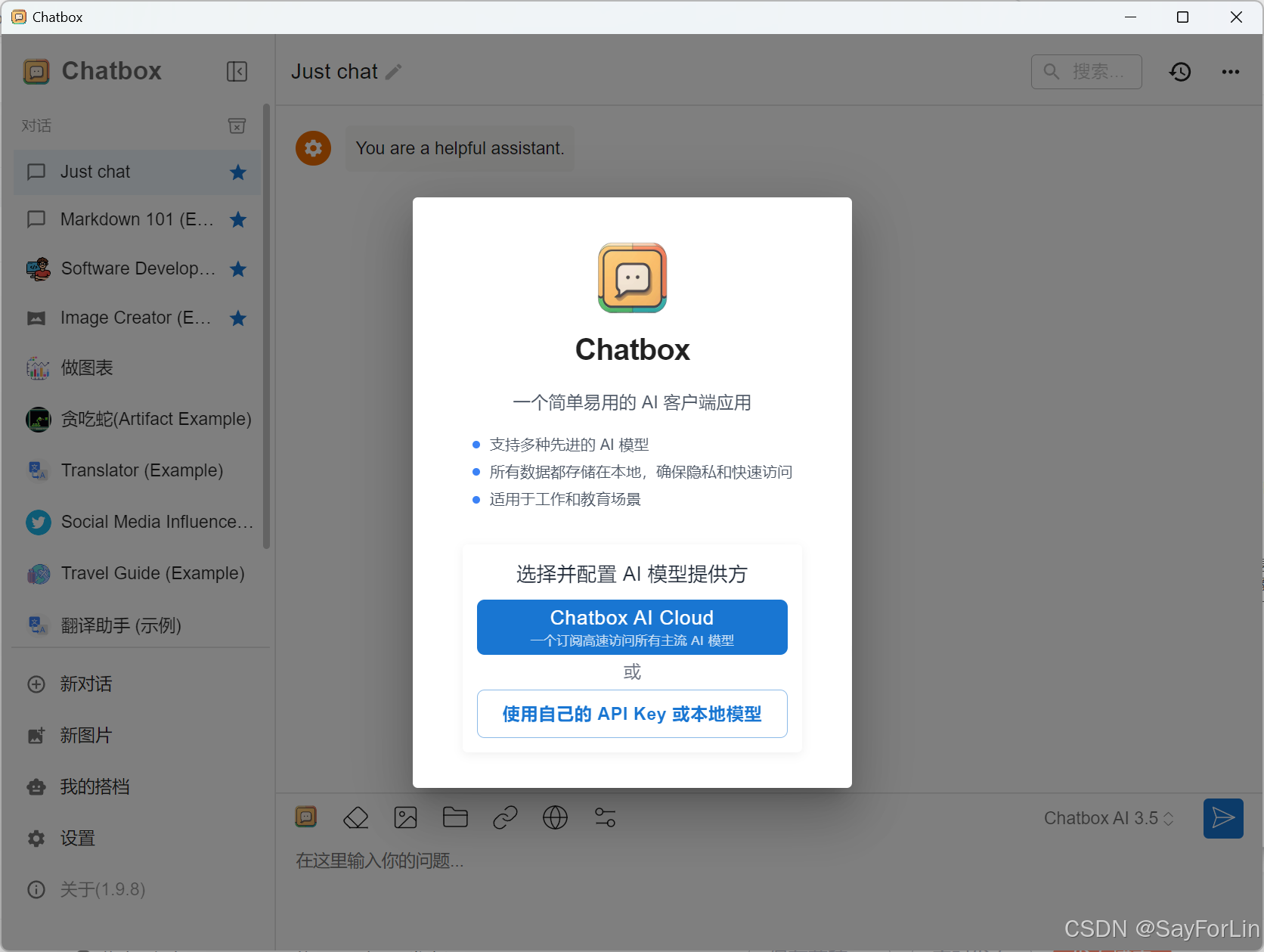

1,Chatbox

Chatbox官方网站:

https://chatboxai.app/en

Windows版下载链接:

https://download.chatboxai.app/releases/Chatbox-1.9.8-Setup.exe

下载安装好 Chatbox 后,打开软件进行关键配置:

选择“使用自己的API Key或本地模型",然后API 类型选择 “Ollama API”,然后保存即可。这一步能确保 Chatbox 与我们部署的 DeepSeek-R1 模型进行正确通信。

接口地址:默认http://127.0.0.1:11434 ,这个地址是 Ollama 服务的默认接口地址,通过它 Chatbox 可以连接到本地运行的 DeepSeek-R1 模型。

模型:选择 deepseek-r1:latest(因为本地只有一个下载的模型)。

然后就可以愉快的聊天了。

2,Open-webui

Open-webui需要python3.11以上版本,而且功能不如Chatbox,不推荐。

三,实际运行

我的笔记本不是Nvidia的显卡,没有实现GPU的运算,不过速度也不错。想看看是用的CPU还是GPU,可以通过以下两个方法:

1,ctrl+alt+delete打开任务管理器,选则性能,然后提一个复杂点的问题,看CPU与GPU的负荷情况。

2,在cmd窗口,运行ollama ps,看使用的运算单元是不是GPU。

以后有时间,再研究一下A卡使用Deepseek的方法。

评论记录:

回复评论: