一、引言

在大模型技术迅猛发展的当下,本地部署大模型的需求日益增长。LM Studio 作为一款强大的工具,允许用户在本地设备上轻松运行大型语言模型,无需依赖昂贵的云端服务,为开发者和爱好者提供了更加灵活、高效且经济的解决方案。它不仅降低了使用大语言模型的门槛,还在隐私保护、网络依赖等方面展现出显著优势。本文将详细介绍 LM Studio 的使用方法,帮助你快速上手,开启本地大模型应用的探索之旅。

二、LM Studio 简介

LM Studio 是一款功能强大的桌面应用程序,旨在让用户能够轻松地在本地设备上运行、管理和部署大型语言模型。它的出现,使得大型语言模型的使用不再局限于拥有强大计算资源和专业技能的用户,普通开发者和爱好者也能通过简单的操作,在自己的电脑上体验大语言模型的魅力。

2.1 核心功能

- 离线运行:LM Studio 最大的优势之一就是支持离线运行大型语言模型。这意味着用户无需依赖网络连接,即可在本地设备上进行文本生成、对话交互等操作 ,极大地提高了使用的便捷性和数据的安全性,有效避免了因网络波动或中断导致的使用问题,同时确保用户数据完全保留在本地,不被上传至云端,充分保护用户隐私。

- 灵活使用模型:用户既可以通过 LM Studio 内置的聊天界面,与模型进行自然流畅的对话,快速获得模型的响应和建议;也可以通过本地设置的 OpenAI 兼容服务器,调用模型 API 。这为将模型集成到其他应用程序中提供了便利,开发者能够基于 LM Studio,开发出各种个性化的应用,拓展大语言模型的应用场景。

- 广泛模型兼容性:LM Studio 支持从 Hugging Face 模型库中下载各种兼容的模型文件,涵盖了基于 ggml 的 Llama、MPT 和 StarCoder 等多个系列。例如,热门的 Llama 2、Orca、Vicuna、Nous Hermes、WizardCoder、MPT 等模型,用户都能在 LM Studio 中轻松获取和使用 ,丰富的模型选择使用户能够根据自己的需求和设备性能,挑选最适合的模型。

- 社区驱动:LM Studio 的主页会展示新发布的和值得关注的 LLM,帮助用户及时了解最新的模型动态和趋势。用户可以在这里发现各种前沿的大语言模型,与社区中的其他用户交流使用心得和经验,共同推动大语言模型技术的发展和应用。这种社区驱动的发现机制,使得 LM Studio 不仅仅是一个工具,更是一个充满活力的大语言模型交流平台。

2.2 支持平台与硬件要求

- 支持平台:LM Studio 支持多种主流操作系统平台,包括拥有支持 AVX2 处理器(通常是较新的 PC)的 Windows 系统 、搭载 macOS 13.6 或更新版本的 Apple Silicon Mac(M1/M2/M3)系统,以及拥有支持 AVX2 处理器(通常是较新的 PC)的 Linux PC(目前为测试版)。这使得不同系统的用户都有机会使用 LM Studio,体验本地运行大语言模型的乐趣。

- 硬件要求:为了确保 LM Studio 能够稳定、高效地运行,对硬件也有一定的要求。建议至少配备 16GB 的 RAM,以保证系统在运行模型时拥有足够的内存空间;对于 PC,建议至少拥有 6GB 的 VRAM,以支持 GPU 加速,提升模型的运行速度和性能;同时,需要有支持 AVX2 指令集的处理器,以满足模型运行的基本计算需求。

三、安装步骤详解

3.1 下载安装包

- Windows 系统:访问 LM Studio 官方网站https://lmstudio.ai/ ,在下载页面找到 “Windows” 选项,点击下载对应的安装包,文件格式通常为.exe。例如,最新版本可能是 “LM-Studio-0.2.XX-Setup.exe” 。如果官网下载速度较慢,可以尝试在一些知名的软件下载平台搜索 “LM Studio” 进行下载,但要注意选择正规可靠的来源,以确保软件的安全性和完整性。

- macOS 系统:同样在 LM Studio 官网,点击 “Mac” 选项,下载.dmg格式的安装包。比如 “LM_Studio_0.2.XX.dmg” 。下载完成后,在 “下载” 文件夹中找到该文件,准备进行安装。

- Linux 系统:官网提供以 AppImage 形式分发的安装文件,适用于拥有支持 AVX2 处理器的 Linux PC 。进入官网下载页面,点击 “Linux” 选项,下载对应的 AppImage 文件,如 “LM_Studio-0.2.XX.AppImage” 。需要注意的是,目前 Linux 版本为测试版,使用过程中可能会遇到一些问题。

3.2 安装过程

- Windows 系统:

-

- 下载完成后,找到下载的.exe安装文件,双击运行。如果系统提示 “Windows 保护你的电脑”,点击 “更多信息”,然后选择 “仍要运行” ,以允许安装程序运行。

-

- 在安装向导界面,点击 “Next” 开始安装。

-

- 阅读许可协议,勾选 “I accept the agreement”,然后点击 “Next”。

-

- 选择安装路径,默认安装在 “C:\Program Files\LM Studio”,如果需要更改路径,点击 “Browse” 选择其他磁盘和文件夹,然后点击 “Next”。例如,可将其安装在空间较大的 D 盘,如 “D:\Program Files\LM Studio” 。

-

- 选择开始菜单文件夹,保持默认即可,点击 “Next”。

-

- 可以选择是否创建桌面快捷方式,根据个人需求勾选,然后点击 “Install” 开始安装。

-

- 安装完成后,点击 “Finish” 完成安装并启动 LM Studio。

- macOS 系统:

-

- 下载完成后,打开 “下载” 文件夹,找到下载的.dmg文件,双击打开。

-

- 将 “LM Studio” 图标拖拽到 “Applications” 文件夹中进行安装。

-

- 安装完成后,在 “Applications” 文件夹中找到 “LM Studio” 图标,双击启动。如果系统提示 “无法打开,因为无法验证开发者”,可前往 “系统偏好设置” - “安全性与隐私”,在 “通用” 选项卡中点击 “仍要打开” ,即可正常启动。

- Linux 系统:

-

- 下载完成后,打开终端,进入下载文件所在目录。例如,如果下载到 “Downloads” 文件夹,可在终端输入 “cd ~/Downloads” 。

-

- 赋予 AppImage 文件可执行权限,在终端输入 “chmod +x LM_Studio-0.2.XX.AppImage” 。

-

- 运行安装文件,输入 “./LM_Studio-0.2.XX.AppImage” ,即可启动 LM Studio。

安装过程中,可能会因网络问题导致下载缓慢或失败,尤其是从 Hugging Face 仓库下载模型文件时。如果遇到这种情况,可以尝试更换网络环境,如切换到更稳定的 Wi-Fi 或使用移动数据网络;也可以使用国内的镜像站点,如 “hf-mirror.com” ,替换默认的 “Hugging Face” 地址,以提高下载速度。此外,安装路径尽量选择磁盘空间充足的位置,避免因磁盘空间不足导致安装失败或后续使用问题 。对于 Windows 系统,建议不要将其安装在系统盘(通常为 C 盘),以免占用过多系统资源,影响系统性能。

四、使用方法

4.1 模型下载与管理

- 模型搜索与筛选:打开 LM Studio,在主界面左侧点击 “Discover” 图标 ,进入模型发现页面。这里有热门模型推荐,也可以在搜索框中输入模型关键词,如 “Llama 2”“Mistral-7B” 等,快速定位目标模型 。在搜索结果页面,还可以通过点击 “Filters” 按钮,按照模型类型、大小、下载量等条件进行筛选 。例如,若你的电脑内存有限,可通过筛选功能,只显示较小尺寸的模型,便于下载和使用。

- 模型下载:找到想要下载的模型后,点击模型卡片进入模型详情页。在详情页中,会展示模型的各项信息,如模型介绍、参数、文件大小等 。点击 “Download” 按钮,选择下载路径,即可开始下载模型文件。下载过程中,可以在界面下方的任务栏查看下载进度 。由于模型文件通常较大,下载时间可能较长,需保持网络稳定。

- 模型管理:下载完成的模型会存储在默认路径或你指定的路径中。在 LM Studio 主界面,点击左侧的 “Models” 图标 ,可进入模型管理页面,这里会列出所有已下载的模型 。你可以对模型进行查看详情、重命名、删除等操作 。比如,当你下载了多个版本的同一模型,可通过重命名操作,为模型添加版本号等标识,方便区分和管理;若某个模型不再使用,可点击 “Delete” 按钮将其从本地删除,释放磁盘空间 。

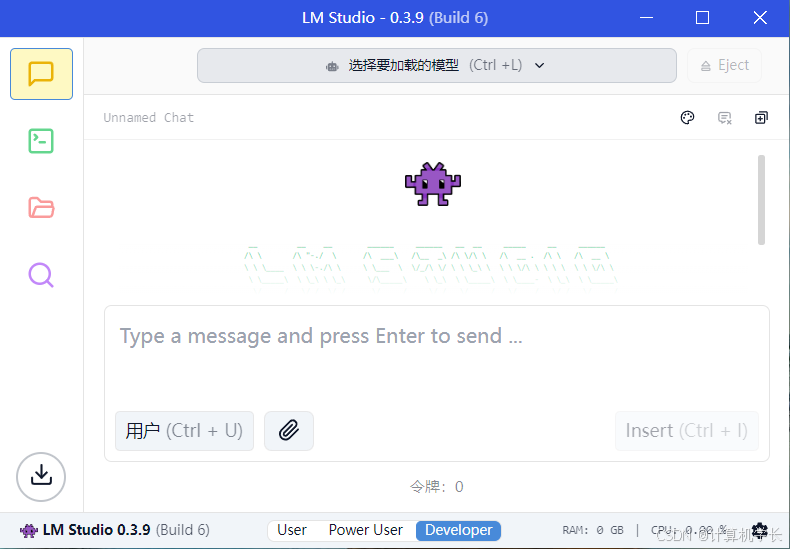

4.2 聊天界面使用

- 界面介绍:点击 LM Studio 主界面左侧的 “AI Chat” 图标 ,进入聊天界面。聊天界面主要分为三部分:左侧是对话历史记录区,会显示你与模型的所有对话内容,方便查看和回顾;中间是聊天输入框,你可以在此输入问题或对话内容;右侧是模型设置和参数调整区,可对模型的相关参数进行设置 。

- 交互方式:在聊天输入框中输入文本后,点击 “Send” 按钮或按下回车键,模型会根据输入内容进行处理,并在对话历史记录区显示回复 。回复过程中,模型会实时生成文本,你可以看到文字逐字出现,就像与真人对话一样 。例如,你可以询问模型 “如何提高写作能力”,模型会给出相应的建议和方法。

- 提问技巧:为了获得更准确、更满意的回答,提问时应尽量表达清晰、具体。比如,不要只问 “帮我写篇文章”,这样的问题过于宽泛,模型可能不知道你需要的文章类型、主题、字数等要求;而 “帮我写一篇 1000 字左右,关于人工智能发展趋势的议论文” 这样的表述就更明确,模型能更好地理解你的需求,生成更符合要求的内容 。此外,还可以在提问中提供一些背景信息,帮助模型更好地理解语境,从而给出更有针对性的回答 。

4.3 本地服务器配置与使用

- 服务器配置:点击 LM Studio 主界面左侧的 “Server” 图标 ,进入本地服务器设置页面。在 “Model” 下拉菜单中选择要使用的模型 ,然后点击 “Start Server” 按钮,即可启动本地服务器 。服务器启动后,会显示服务器的地址和端口号,默认地址为 “localhost”,端口号为 “1234” 。如果需要更改端口号,可在 “Port” 输入框中自行修改 。

- API 调用方法:通过本地服务器,你可以使用 OpenAI 兼容的 API 来调用模型。以 Python 为例,首先需要安装openai库,可在命令行中输入 “pip install openai” 进行安装 。安装完成后,使用以下代码进行 API 调用:

from openai import OpenAI

# 指向本地服务器

client = OpenAI(base_url="http://localhost:1234/v1", api_key="lm-studio")

completion = client.chat.completions.create(

model="TheBloke/Mistral-7B-Instruct-v0.2-GGUF",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Translate the following English text to Chinese: 'Hello, world!'"}

]

)

print(completion.choices[0].message.content)

在上述代码中,base_url设置为本地服务器的地址和端口号,api_key设置为 “lm - studio” ,model指定要使用的模型,messages中包含了对话的角色和内容 。运行这段代码,即可通过本地服务器调用模型,实现文本翻译功能 。

4.4 文本嵌入功能(测试版)

- 文本嵌入概念:文本嵌入是将文本表示为数字向量的一种方式,这些向量能够捕捉文本的语义信息,使得计算机可以更好地理解和处理文本 。在实际应用中,文本嵌入常用于检索增强生成(RAG)、文本相似度计算、文本分类等任务 。例如,在一个文档检索系统中,通过将文档和查询都转换为文本嵌入向量,然后计算向量之间的相似度,就可以快速找到与查询相关的文档 。

- 使用方法:在 LM Studio 主界面,点击左侧的 “Server” 图标进入服务器设置页面。在 “Embedding Model Settings” 下拉菜单中选择支持文本嵌入的模型 ,如 “nomic-embed-text-v1” 。点击 “Start Server” 按钮启动服务器 。使用 POST 请求访问 “/v1/embeddings” 端点,即可获取文本的嵌入向量 。以下是一个使用 Python 进行请求的示例:

import requests

import json

url = "http://localhost:1234/v1/embeddings"

headers = {

"Content-Type": "application/json"

}

data = {

"input": "This is a sample text for embedding.",

"model": "nomic-embed-text-v1"

}

response = requests.post(url, headers=headers, data=json.dumps(data))

if response.status_code == 200:

embedding = response.json()["data"][0]["embedding"]

print(embedding)

else:

print("Error:", response.status_code, response.text)

在上述代码中,url设置为本地服务器的地址和端口号加上 “/v1/embeddings” 端点,headers设置为请求头,data中包含了要嵌入的文本和使用的模型 。运行代码后,若请求成功,将返回文本的嵌入向量 。

五、常见问题及解决方案

5.1 下载失败

- 网络问题:由于 LM Studio 的服务器可能位于国外,下载速度可能会受到网络状况的影响。若遇到网络波动、DNS 解析错误或网络连接不稳定,都可能导致下载失败。你可以尝试使用科学上网工具来改善网络连接;也可以进行网络诊断,如使用 ping 命令检查网络连通性,使用 tracert 命令追踪网络路由,查找网络问题所在;还可以等待网络状况改善后,再次尝试下载。

- 镜像问题:LM Studio 主要从 Hugging Face 仓库下载模型文件,而国内网络访问 Hugging Face 可能存在限制,导致下载失败。此时,你可以使用国内的镜像站点,如 “hf-mirror.com” 。具体操作方法是:用文件搜索工具(如 everything)搜索 “cache\lm-studio” 找到目录;用编辑器打开相关文件(如 downloads.json),将文件中的 “https://huggingface.co/” 替换为 “hf-mirror.com” ;保存文件后,重新启动 LM Studio,点击 “Resume” 即可继续下载 。

- 磁盘空间不足:若下载路径所在磁盘空间不足,也会导致下载失败。你可以检查磁盘空间,清理不必要的文件,释放磁盘空间;或者更改下载路径,选择磁盘空间充足的位置进行下载 。例如,若默认下载路径为 C 盘,而 C 盘空间紧张,可将下载路径更改为空间较大的 D 盘。

5.2 模型加载异常

- 模型兼容性问题:不同版本的 LM Studio 可能对模型的兼容性有所不同,某些模型可能在特定版本的 LM Studio 中无法正常加载。你需要检查模型与 LM Studio 版本的兼容性,查看官方文档或社区论坛,了解哪些模型版本适用于当前的 LM Studio 版本;若模型不兼容,尝试更换兼容的模型版本 。

- 模型文件损坏:在下载过程中,若出现网络中断、磁盘读写错误等问题,可能导致模型文件损坏,从而无法正常加载。你可以重新下载模型文件,确保下载过程的完整性;在下载前,还可以验证模型文件的哈希值(如 SHA256) ,确保下载的文件与官方提供的哈希值一致,以判断文件是否完整。

- 系统环境问题:某些模型对系统环境有特定要求,如操作系统版本、显卡驱动版本等。如果系统环境不符合要求,可能导致模型加载异常。你需要确保系统环境满足模型的要求,如更新操作系统到最新版本、更新显卡驱动到官方推荐版本 ;对于一些需要特定依赖库的模型,还需确保已安装相应的依赖库 。

5.3 服务器连接问题

- 端口冲突:若本地服务器设置的端口号被其他程序占用,会导致服务器无法启动或连接失败。你可以使用端口查看工具(如 TCPView),检查端口占用情况;若发现端口被占用,可在 LM Studio 的服务器设置页面中,更改端口号,选择一个未被占用的端口 。

- 防火墙限制:防火墙可能会阻止 LM Studio 与本地服务器之间的连接。你可以检查防火墙设置,将 LM Studio 添加到信任列表中,允许其通过防火墙;或者暂时关闭防火墙,测试连接是否正常 。若使用的是 Windows 防火墙,可在防火墙设置中找到 “允许应用或功能通过 Windows 防火墙” 选项,在列表中找到 LM Studio 并勾选允许其通信。

- 服务器配置错误:在设置本地服务器时,若模型选择错误、地址或端口设置错误,都可能导致连接问题。你需要仔细检查服务器配置,确保模型选择正确,服务器地址和端口设置无误 ;若不确定如何配置,可参考官方文档或示例代码进行设置 。

六、总结与展望

通过本文的详细介绍,我们全面了解了 LM Studio 的使用方法,从下载安装、模型管理,到聊天交互、本地服务器配置以及文本嵌入功能的应用,同时也掌握了常见问题的解决技巧。LM Studio 以其强大的功能和易用性,为本地大语言模型的运行和应用提供了便捷的解决方案,无论是对于个人开发者探索大语言模型的潜力,还是企业构建基于大语言模型的应用,都具有重要的价值。

展望未来,随着大语言模型技术的不断进步,LM Studio 有望在以下几个方面取得更大的发展。在功能上,它可能会进一步优化模型加载和运行速度,提升用户体验;支持更多类型的模型和格式,拓展模型选择范围;增强文本嵌入功能,为更多高级应用场景提供更强大的支持。在兼容性方面,预计会更好地适配不同硬件和操作系统,降低使用门槛,让更多用户能够轻松使用。此外,随着社区的不断壮大,LM Studio 将获得更多的技术支持和资源,推动其持续创新和发展。

如果你对大语言模型感兴趣,想要在本地体验大语言模型的强大功能,不妨立即尝试使用 LM Studio。它将为你打开一扇通往本地大语言模型应用世界的大门,开启一段充满创新和探索的技术之旅。

评论记录:

回复评论: