差分隐私

中心化DP (CDP):依赖可信第三方聚合数据并添加噪声(如拉普拉斯/高斯噪声),隐私保护强度高但需信任中心节点。

本地化DP (LDP):用户端直接扰动数据(如随机响应技术),无需信任第三方,但效用较低(如苹果、谷歌的隐私数据收集方案)。

放宽条件变体:放宽严格DP定义以提升实用性,例如:

松弛DP:(ε, δ)-DP(允许小概率δ的隐私泄露)。

零集中DP (zCDP):优化组合场景下的隐私损失边界。

组合性与预算管理:

组合定理:分析多步查询的隐私损失累积(如线性组合、高级组合定理)。

自适应预算分配:动态分配隐私预算(ε)到不同查询阶段,最大化数据效用(如深度学习训练中的逐层噪声注入)。

技术融合创新:

DP+安全多方计算(MPC):实现隐私计算的全链路保护。

大模型隐私保护:针对LLM训练/推理设计轻量级DP方案(如参数扰动、提示工程隐私)。

当前研究正从理论验证转向场景驱动,重点关注:

低信噪比优化:提升高隐私要求(ε < 1)下的数据可用性。

全生命周期DP:覆盖数据采集、传输、计算、销毁各阶段。

可解释性增强:量化隐私泄露风险并提供用户可控接口。

相关综述文献推荐:

Dwork & Roth (2014)《The Algorithmic Foundations of Differential Privacy》基础理论。

Yang et al. (2020)《Local Differential Privacy and Its Applications: A Comprehensive Survey》本地化DP进展。

Liu et al. (2023)《Differential Privacy in Machine Learning: A Survey》ML场景应用深度分析。

对差异隐私的解释

训练数据、模型训练过程和模型输出结果中引入校准噪声是将差分隐私注入原型深度学习模型的三种通用策略

差分隐私的目标是确保单个记录的存在或不存在对任何分析任务的输出的影响可以忽略不计。

简洁起见,我们将训练数据隐私相关的攻击分为三种核心类型:模型反转攻击[49-51]、隶属度推理攻击[52-55]和属性推理攻击[56-58]。

对深度学习模型可能存在的被攻击方法

模型反转攻击

核心目标是利用模型的输出特征或中间结果,重构原始输入数据或推断隐私属性。、

单方场景下:

攻击者通过观察模型的输出(如预测结果),发现非敏感属性(如年龄、性别)与敏感属性(如疾病、收入)之间的统计相关性,并利用这种相关性构建推理模型。

多方学习场景下

Hitaj等人的攻击方法:

伪装攻击者:攻击者通过发送恶意参数(如梯度)干扰训练过程,诱使其他参与方(受害者)泄露更多敏感数据的特征

GAN辅助重建:攻击者利用生成对抗网络(GAN),基于受害者上传的梯度或中间特征,生成与受害者原始数据高度相似的合成样本。

Wang等人的多任务模型反演攻击:

恶意服务器假设:攻击者控制中央服务器,在不显式修改训练过程的情况下,通过分析多方上传的模型参数或中间结果,分离出特定参与者的数据特征。

隶属度推理

攻击者试图推断某个数据样

构建影子模型:攻击者首先构建一个与目标模型相似的影子模型,并使用一组已知的数据集对其进行训练。

收集信息:攻击者利用影子模型对一组已知的训练样本和非训练样本进行预测,并记录预测结果

训练分类器:基于这些预测结果,攻击者训练一个分类器,该分类器能够区分哪些样本是训练样本,哪些不是。

应用到目标模型:最后,攻击者将这个分类器应用于目标模型的预测结果,以推断哪些样本可能是训练数据的一部分。

本是否属于训练数据集的一种隐私攻击

属性推理攻击

独立于学习任务的属性进行推理,也就是说,这些属性与训练模型打算捕获的信息无关。推断出的属性可能与整个训练数据相关,也可能是指一批训练数据。

模型反转攻击关注的是从模型中重建出原始训练数据的具体实例;

隶属度推理攻击侧重于判断特定的数据点是否出现在训练集中;

属性推理攻击则更进一步,目的是了解训练数据集的整体属性或统计特性

差分隐私如何防御攻击

对隶属度推理攻击的防护:

差分隐私通过添加噪声,使得攻击者难以确定某个数据点是否属于训练集,从而降低了隶属度推理攻击的成功率。

对模型反转攻击的防护:

差分隐私通过绑定单个数据记录对模型输出的影响,使得攻击者难以从模型输出中恢复原始数据点。(在训练阶段注入噪声)

对属性推理攻击的防护:

传统差分隐私方法对属性推理攻击的防护效果有限,需要特定的保护方法,如用户级差分隐私。

深度学习中加入扰动的位置

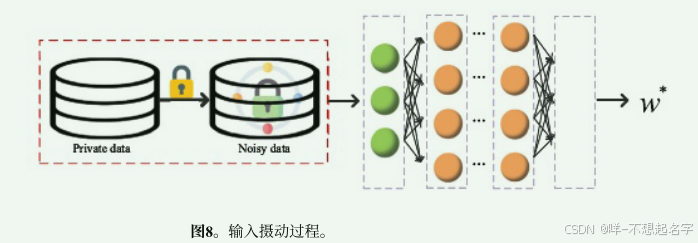

1、输入摄动(如图8)

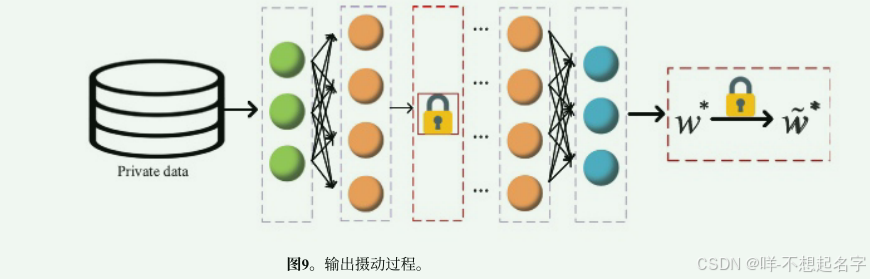

2、输出摄动(如图9)

3、客观摄动

4、梯度摄动

客观摄动主要是在目标函数中添加噪声,适用于对目标函数形式有严格要求的情况。

梯度摄动主要是在梯度中添加噪声,适用于实际的机器学习任务,能够提供更好的模型性能。

单方学习与差分隐私

- 动态隐私预算分配策略

背景:为了在保持模型性能的同时减少隐私预算的积累,Lee等人[88]设计了一种动态隐私预算分配策略。

策略:

计算扰动梯度:该策略允许部分隐私预算能够在每次迭代期间计算扰动梯度。

选择最优步长:使用基于差分隐私有噪声最小算法[46]的余量来选择最优步长,以确保注入梯度的扰动不会太大而导致分配无意义。 - 快速收敛和不妥协精度的差分私有深度学习算法

相关研究:在[89,90]中讨论了具有快速收敛和不妥协精度的差分私有深度学习算法。

抵抗隶属度攻击的能力:在[90]中探讨了抵抗隶属度攻击能力的说明。 - 编码梯度和噪声分布

Nasr等人[91]:

梯度编码:首先将梯度编码到更小的向量空间中。

计算噪声分布:然后使用编码梯度的距离来计算噪声分布的隐私界。 - 梯度嵌入微扰算法

Yu等人[92]:

开发算法:开发了一种梯度嵌入微扰算法。

有限维数:由于梯度嵌入的维数是有限的,因此噪声方差明显减小,而注入该嵌入的扰动能是有限的。

总结:

四种摄动都可以缓解隶属度推理攻击。但是对于属性推理攻击的抵御是未知的;

虽然已经能证明差异隐私可以提供隐私保护水平,但是很少有研究或方法详细探讨并明确它们抵御特定类型的模型攻击(如成员推理攻击、模型反转攻击等)的实际能力和强度。换句话说,虽然知道这些方法能在统计意义上提供隐私保护,但对于具体的攻击手段,它们能防御到什么程度并不总是清楚的;

许多这样的方法并没有清晰地定义什么是“数据隐私”。这里的数据隐私可以指不同的层面,例如:

单个数据记录的隐私。

某些数据记录(比如具有某些特征的记录)的集合隐私。

单个特征值的隐私。

关于训练数据集的整体特性或统计信息的隐私。

由于缺乏明确定义,导致在实际应用场景中,“数据隐私”到底意味着什么变得模糊不清。这可能影响用户对这些方法真正能够提供的隐私保护级别的理解,也可能限制了这些方法在更广泛场景下的有效应用;

在保持模型性能的同时,寻求一种有效削减隐私预算支出的方法也是一个迫切的需求。

多方安全与差分隐私

在输入中加入噪声

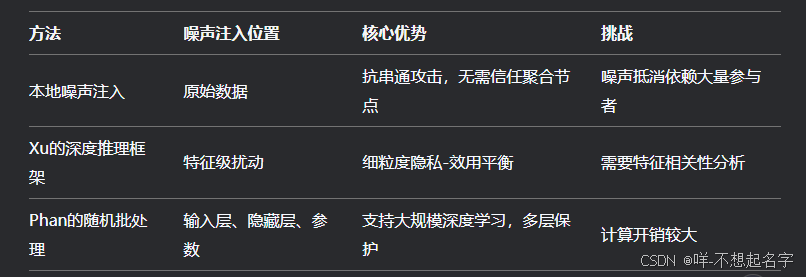

可将本地噪声注入与Phan的随机批处理结合,实现“数据-特征-参数”多层隐私防护;Xu的特征级扰动可用于优化Phan方法中的隐藏层噪声分配

在输出中加入噪声

-

PATE框架(Papernot等人)

核心机制:

构建一个由多个“教师”模型组成的集合,每个教师模型在互不相交的敏感数据集上独立训练。当对新的未标记数据进行预测时,教师模型通过投票机制生成预测结果(例如分类任务中的类别投票)。

噪声添加:在投票计数中加入噪声(如拉普拉斯噪声),以隐藏单个教师模型的预测细节,满足差分隐私(DP)要求。

知识转移:利用公开的未标记数据训练一个“学生”模型,使其学习教师集合的有噪声投票结果。学生模型不直接接触原始敏感数据,从而减少隐私泄露风险。

隐私保护逻辑:

教师模型的预测结果被噪声扰动,确保攻击者无法通过输出反推单个教师模型的训练数据。

学生模型通过半监督学习间接获取知识,进一步降低隐私损失(隐私预算的组成定理)。 -

服务器端噪声添加(Geyer等人)

核心机制:

在联邦学习等分布式场景中,参与者的本地模型更新(如梯度)上传到服务器后,服务器在聚合所有更新时向总和添加噪声(例如高斯噪声)。

目标:隐藏单个参与者的贡献,防止通过聚合结果反推某个参与者的数据。

隐私保护逻辑:

噪声的添加满足差分隐私的全局敏感度要求,确保即使服务器是“诚实但好奇”的,也无法推断出单个参与者的信息。

缺点:全局噪声可能降低模型整体性能,需权衡隐私保护强度与模型效用。 -

本地参数扰动(后续研究,如[93,100-104])

核心机制:

要求每个参与者在共享模型参数(如梯度、权重)前,本地添加噪声进行扰动,再将扰动后的参数上传至服务器。

目标:提供更强的数据隐私保护,抵御更强大的攻击者(如恶意服务器或串通参与者)。

隐私保护逻辑:

本地扰动符合本地差分隐私(LDP) 定义,确保单个参与者的数据在本地处理阶段即被保护。

优点:参与者可自主控制隐私预算,无需信任服务器。

缺点:本地噪声可能导致模型收敛困难,需设计高效的噪声机制(如稀疏扰动、自适应噪声)。

PATE可与安全聚合(Secure Aggregation)结合,防止服务器窥探单个教师模型的更新;本地扰动可与同态加密结合,实现隐私增强的多方计算。

总结(结合安全多方计算 和 自适应噪声机制)

对手模型的多样性:不同的差分私有多方学习模型基于不同的假设,例如服务器或参与者可能是“诚实但好奇”的,或者存在恶意的外部攻击者。然而,很少有模型能够同时抵御多种类型的对手,尤其是在多个参与者可能串通的情况下。因此,需要一个更全面的框架来处理这些不同的威胁。

隐私保护级别:记录级差分隐私可能不足以保护多方设置中的隐私。用户级差分隐私可能更适合,因为它提供了更有效的隐私保障。此外,仅依赖差分隐私可能无法在提高模型精度的同时实现全面的隐私保护,因此需要结合其他隐私保护技术。

系统结构的挑战:在多方学习系统中,除了隐私保护,还需要考虑通信开销、系统异构性和数据分布不均等问题。在这些问题与隐私保护之间找到平衡是一个重要的研究方向。

公平性和激励机制:在应用差分私有多方学习时,公平性和激励机制至关重要。由于计算成本、通信支出和隐私风险,数据所有者可能不愿意参与模型训练。因此,设计良好的激励机制和公平性保障是鼓励数据所有者参与的关键。每个数据所有者都有自己的利益,参与度越高,对资源和隐私保护的要求也越高,因此公平性是不可忽视的。

评论记录:

回复评论: