一、引言

在当今人工智能飞速发展的时代,卷积神经网络(Convolutional Neural Network,简称 CNN)无疑在诸多领域发挥着关键作用,尤其在计算机视觉领域,如人脸识别、图像分类、目标检测等任务中,CNN 已成为不可或缺的技术。它能够自动从大量数据中学习特征,大大减少了人工特征工程的工作量,并且在性能上超越了许多传统的机器学习方法。

尽管 CNN 在实际应用中取得了巨大的成功,但其背后的数学原理和复杂的内部机制却常常让初学者望而却步。很多人在使用 CNN 时,更多的是基于现成的框架和工具,对其底层的工作原理缺乏深入的理解。然而,深入了解 CNN 的数学原理,不仅有助于我们更好地调优模型、提高性能,还能让我们在面对各种复杂问题时,更加灵活地设计和改进网络结构。

同时,可视化技术作为理解 CNN 的重要辅助手段,能够将抽象的特征和复杂的计算过程直观地展现出来,帮助我们洞察网络内部的工作机制,发现模型的优点和不足。通过可视化,我们可以看到卷积核是如何提取图像特征的,不同层的特征图是如何变化的,以及模型的决策过程是怎样的。

本文将深入探讨卷积神经网络的数学原理和可视化方法,从基础概念到核心算法,再到实际的可视化操作,逐步揭开 CNN 的神秘面纱,帮助读者深入理解这一强大的人工智能技术 。

二、卷积神经网络的数学原理

(一)数字图像的数据结构

在计算机中,数字图像是以矩阵的形式存储的。对于灰度图像,它可以看作是一个二维矩阵,矩阵中的每个元素代表图像中对应位置像素的灰度值,灰度值的范围通常是 0 到 255,0 表示黑色,255 表示白色,中间值则表示不同程度的灰色。例如,一个大小为 m × n m \times n m×n 的灰度图像,就可以用一个 m × n m \times n m×n 的矩阵来表示。

而对于 RGB 彩色图像,它由三个通道(红色 Red、绿色 Green、蓝色 Blue)组成,每个通道都可以看作是一个独立的灰度图像矩阵。因此,RGB 彩色图像在计算机中存储为一个三维张量,形状为 h × w × 3 h \times w \times 3 h×w×3,其中 h h h 和 w w w 分别表示图像的高度和宽度,3 表示通道数 。每个通道的矩阵元素同样表示对应位置像素在该颜色通道上的强度值,范围也是 0 到 255。通过这三个通道不同强度值的组合,就可以表示出丰富多彩的颜色。

(二)卷积核与卷积运算

卷积核(Convolution Kernel),也被称为滤波器(Filter),是一个小型的矩阵,在卷积神经网络中扮演着至关重要的角色。它的主要作用是对输入的图像或特征图进行卷积运算,从而提取出其中的特征。卷积核的大小通常是奇数,如 3 × 3 3 \times 3 3×3、 5 × 5 5 \times 5 5×5 等,这样可以保证在卷积过程中有一个明确的中心位置。

卷积运算的过程可以用以下步骤来描述:

-

首先,将卷积核放置在输入图像的左上角位置,使得卷积核的每个元素与输入图像对应位置的元素一一对应。

-

然后,将卷积核与对应位置的图像元素进行相乘,并将所有乘积结果相加,得到输出特征图中对应位置的一个元素值。

-

接着,将卷积核沿着输入图像的水平和垂直方向逐像素滑动,每次滑动一个像素的距离,重复上述相乘和相加的操作,直到卷积核遍历完整个输入图像,从而得到完整的输出特征图。

用数学公式表示,假设输入图像为 I I I,卷积核为 K K K,输出特征图为 O O O,则卷积运算可以表示为:

O ( i , j ) = ∑ m ∑ n I ( i + m , j + n ) × K ( m , n ) O(i,j) = \sum_{m}\sum_{n} I(i + m,j + n) \times K(m,n) O(i,j)=m∑n∑I(i+m,j+n)×K(m,n)

其中, ( i , j ) (i,j) (i,j) 表示输出特征图中元素的位置, ( m , n ) (m,n) (m,n) 表示卷积核中元素的位置 。

例如: 假设有一个 5 × 5 5 \times 5 5×5 的输入图像和一个 3 × 3 3 \times 3 3×3 的卷积核,进行卷积运算时,首先将卷积核放在输入图像的左上角,计算 3 × 3 3 \times 3 3×3 区域内对应元素的乘积之和,得到输出特征图左上角的第一个元素值。然后,卷积核向右滑动一个像素,再次计算对应区域的乘积之和,得到输出特征图的第二个元素值,以此类推,直到得到整个 3 × 3 3 \times 3 3×3 的输出特征图。

(三)Valid 和 Same 卷积

在卷积运算中,根据是否对输入图像进行填充(Padding),可以分为 Valid 卷积和 Same 卷积两种方式。

-

Valid 卷积:也称为无填充卷积,在这种卷积方式下,卷积核只在输入图像中完全包含的区域内进行滑动,不进行任何填充操作。这就导致输出特征图的尺寸会小于输入图像的尺寸。

例如,对于一个大小为 H × W H \times W H×W的输入图像,使用大小为 h × w h \times w h×w的卷积核进行 Valid 卷积,输出特征图的高度 H o u t H_{out} Hout和宽度 W o u t W_{out} Wout可以通过以下公式计算:

H o u t = H − h + 1 H_{out} = H - h + 1 Hout=H−h+1 W o u t = W − w + 1 W_{out} = W - w + 1 Wout=W−w+1 -

Same 卷积:为了使输出特征图的尺寸与输入图像相同,Same 卷积会在输入图像的边缘进行填充(通常填充值为 0),然后再进行卷积运算。填充的行数和列数会根据卷积核的大小来确定,以保证卷积核能够覆盖到输入图像的每一个像素。

- 对于 Same 卷积,当卷积核大小为奇数时,填充的行数和列数为 ( h − 1 ) / 2 (h - 1) / 2 (h−1)/2 和 ( w − 1 ) / 2 (w - 1) / 2 (w−1)/2;

- 当卷积核大小为偶数时,填充的行数和列数需要根据具体的实现方式来确定,以确保输出尺寸与输入尺寸相同。

例如,对于一个大小为 H × W H \times W H×W 的输入图像,使用大小为 h × w h \times w h×w 的卷积核进行 Same 卷积,输出特征图的高度 H o u t H_{out} Hout 和宽度 W o u t W_{out} Wout 与输入图像相同,即 H o u t = H H_{out} = H Hout=H, W o u t = W W_{out} = W Wout=W 。

(四)步幅卷积

步幅(Stride)是卷积运算中的另一个重要参数,它指的是卷积核在输入图像上每次滑动的像素数。在前面的例子中,我们默认步幅为 1,即卷积核每次滑动一个像素的距离。然而,当步幅大于 1 时,卷积核会跳过一些像素进行滑动,这样可以加快卷积运算的速度,同时减小输出特征图的尺寸。

例如,当步幅为 2 时,卷积核每次会向右和向下滑动 2 个像素。对于一个大小为 H × W H \times W H×W 的输入图像,使用大小为 h × w h \times w h×w的卷积核,步幅为 s s s进行卷积运算,输出特征图的高度 H o u t H_{out} Hout 和宽度 W o u t W_{out} Wout 可以通过以下公式计算:

H o u t = ⌊ H − h + 2 p s ⌋ + 1 H_{out} = \lfloor \frac{H - h + 2p}{s} \rfloor + 1 Hout=⌊sH−h+2p⌋+1 W o u t = ⌊ W − w + 2 p s ⌋ + 1 W_{out} = \lfloor \frac{W - w + 2p}{s} \rfloor + 1 Wout=⌊sW−w+2p⌋+1

其中, p p p 表示填充的像素数, ⌊ ⋅ ⌋ \lfloor \cdot \rfloor ⌊⋅⌋ 表示向下取整操作。

步幅的大小会对卷积结果产生显著影响。较大的步幅可以快速减小特征图的尺寸,减少计算量,但可能会丢失一些细节信息;较小的步幅则可以保留更多的细节信息,但计算量会相应增加。在实际应用中,需要根据具体的任务和需求来选择合适的步幅。

(五)3D 卷积与多通道卷积

在前面的介绍中,我们主要讨论了二维卷积,即卷积核在二维平面上对图像进行操作。然而,在处理彩色图像或具有多个通道的特征图时,需要使用 3D 卷积。3D 卷积不仅考虑了图像在水平和垂直方向上的信息,还考虑了通道维度上的信息。

对于彩色图像,如 RGB 图像,每个像素点由三个通道(红、绿、蓝)组成。在进行 3D 卷积时,卷积核也具有三个通道,并且每个通道的卷积核分别与输入图像的对应通道进行卷积运算,然后将三个通道的卷积结果相加,得到输出特征图中的一个通道。例如,假设有一个大小为 H × W × 3 H \times W \times 3 H×W×3 的 RGB 图像,使用一个大小为 h × w × 3 h \times w \times 3 h×w×3的 3D 卷积核进行卷积运算:

- 首先,将卷积核的红色通道与图像的红色通道进行二维卷积,得到一个大小为 H o u t × W o u t H_{out} \times W_{out} Hout×Wout 的特征图;

- 然后,将卷积核的绿色通道与图像的绿色通道进行二维卷积,得到另一个大小为 H o u t × W o u t H_{out} \times W_{out} Hout×Wout 的特征图;

- 最后,将卷积核的蓝色通道与图像的蓝色通道进行二维卷积,得到第三个大小为 H o u t × W o u t H_{out} \times W_{out} Hout×Wout 的特征图。

将这三个特征图对应元素相加,就得到了输出特征图中的一个通道。如果需要得到多个通道的输出特征图,则可以使用多个 3D 卷积核,每个卷积核生成一个通道的输出。

多通道卷积是 3D 卷积的一种扩展,它可以同时使用多个卷积核对输入图像进行卷积运算。每个卷积核都可以提取不同的特征,从而得到多个通道的输出特征图。例如,在一个卷积层中,可以使用 16 个或 32 个卷积核,每个卷积核生成一个通道的输出,最终得到一个大小为 H o u t × W o u t × C o u t H_{out} \times W_{out} \times C_{out} Hout×Wout×Cout 的输出张量,其中 C o u t C_{out} Cout 表示输出通道数。

(六)卷积层的参数共享与连接切割

卷积层的一个重要特点是参数共享和连接切割,这使得卷积神经网络在处理图像时能够大大减少参数的数量,提高计算效率。

-

参数共享:在卷积层中,一个卷积核会在整个输入图像上滑动进行卷积运算,卷积核的参数在不同的位置上是共享的。这意味着无论卷积核在图像的哪个位置进行卷积,它所使用的权重参数都是相同的。

例如,一个 3 × 3 3 \times 3 3×3 的卷积核在对一个 100 × 100 100 \times 100 100×100 的图像进行卷积时,卷积核的 9 个参数会被重复使用 98 × 98 98 \times 98 98×98 次(假设步幅为 1)。相比之下,如果是全连接层,每个神经元都需要与输入图像的每个像素进行连接,参数数量会非常庞大。参数共享的优点在于,一方面减少了需要学习的参数数量,降低了模型的复杂度和训练的难度;另一方面,使得卷积核能够对图像的不同位置提取相同的特征,增强了模型的泛化能力。

-

连接切割:卷积层中的每个神经元只与输入图像的局部区域进行连接,而不是与整个输入图像连接。这个局部区域的大小由卷积核的大小决定。

例如,一个 3 × 3 3 \times 3 3×3的卷积核对应的局部连接区域就是一个 3 × 3 3 \times 3 3×3的像素块。这种局部连接的方式使得模型能够专注于提取图像的局部特征,同时减少了计算量。因为每个神经元只需要处理局部区域的信息,而不需要处理整个图像的信息。与全连接层相比,全连接层中每个神经元都与输入层的所有神经元连接,计算量巨大。通过连接切割,卷积层能够有效地降低计算复杂度,提高模型的运行效率。

(七)池化层原理

池化层(Pooling Layer)是卷积神经网络中的另一个重要组成部分,它通常位于卷积层之后,其主要作用是对特征图进行下采样,降低特征图的维度,减少计算量,同时在一定程度上还能防止过拟合。

常见的池化操作有最大池化(Max Pooling)和平均池化(Average Pooling)两种。

-

最大池化(Max Pooling):最大池化的操作是将特征图划分为若干个不重叠的子区域,在每个子区域中选择最大值作为该子区域的输出。

例如,对于一个大小为 H × W H \times W H×W的特征图,使用大小为 2 × 2 2 \times 2 2×2的池化窗口进行最大池化,将特征图划分为若干个 2 × 2 2 \times 2 2×2的子区域,每个子区域中选择最大的元素作为输出,这样输出特征图的大小就变为 H / 2 × W / 2 H/2 \times W/2 H/2×W/2(假设步幅与池化窗口大小相同)。最大池化能够保留特征图中的主要特征,因为它选择的是子区域中的最大值,这些最大值往往代表了图像中最显著的特征。

-

平均池化(Average Pooling):平均池化则是将特征图划分为若干个不重叠的子区域,计算每个子区域中所有元素的平均值作为该子区域的输出。

同样以大小为 2 × 2 2 \times 2 2×2的池化窗口为例,对每个 2 × 2 2 \times 2 2×2的子区域中的 4 个元素求平均值,得到输出特征图中的一个元素。平均池化能够平滑特征图,减少噪声的影响,但相对来说会丢失一些细节信息。

池化层通过降低特征图的维度,减少了后续全连接层的参数数量和计算量,同时由于下采样的作用,使得模型对输入图像的小位移、旋转等变化具有一定的鲁棒性,从而在一定程度上防止过拟合。

(八)激活函数的作用

在卷积神经网络中,激活函数(Activation Function)起着至关重要的作用。它为神经网络引入了非线性因素,使得神经网络能够学习复杂的模式和特征。如果没有激活函数,神经网络就只是一个线性模型,只能学习线性关系,其表达能力非常有限。

常见的激活函数有 ReLU(Rectified Linear Unit)、Sigmoid、Tanh 等。

-

ReLU 函数:其数学表达式为: f ( x ) = m a x ( 0 , x ) f(x) = max(0, x) f(x)=max(0,x)即当 x x x 大于 0 时,输出为 x x x;当 x x x 小于等于 0 时,输出为 0。

ReLU 函数的优点是计算简单,收敛速度快,能够有效缓解梯度消失问题。在实际应用中,ReLU 函数被广泛使用,尤其是在深层神经网络中。

-

Sigmoid 函数:数学表达式为: f ( x ) = 1 1 + e − x f(x) = \frac{1}{1 + e^{-x}} f(x)=1+e−x1它的输出值在 0 到 1 之间,可以将其看作是对输入的一种概率估计。

Sigmoid 函数在早期的神经网络中应用较多,但由于其存在梯度消失问题,在深层神经网络中的表现不如 ReLU 函数。

-

Tanh 函数:数学表达式为: f ( x ) = e x − e − x e x + e − x f(x) = \frac{e^{x} - e^{-x}}{e^{x} + e^{-x}} f(x)=ex+e−xex−e−x它的输出值在 - 1 到 1 之间,是一个奇函数。

Tanh 函数与 Sigmoid 函数类似,但在某些情况下,其表现优于 Sigmoid 函数,因为它的输出均值为 0,能够使数据更好地分布在 0 附近 。

通过在卷积层和全连接层之后添加激活函数,神经网络能够学习到更加复杂的特征,从而提高模型的性能和泛化能力。

三、卷积神经网络的可视化

(一)可视化的意义

虽然卷积神经网络在众多任务中表现卓越,但其内部的工作机制却相对复杂,常被视为 “黑箱” 模型 。可视化技术则为我们打开了一扇了解这个 “黑箱” 的窗户,具有至关重要的意义。

从理解模型内部机制的角度来看,通过可视化,我们能够直观地看到卷积核是如何在图像上滑动并提取特征的,不同层的特征图是如何随着网络层次的加深而逐渐抽象化的。例如,在图像分类任务中,我们可以看到底层的卷积层主要提取图像的边缘、颜色等低级特征,而高层的卷积层则能够学习到更复杂、更抽象的语义特征,如物体的部分结构或整体形状。这有助于我们深入理解卷积神经网络是如何从原始图像数据中逐步学习到对分类或其他任务有用的信息的。

在发现模型问题方面,可视化也发挥着关键作用。当模型出现性能不佳或分类错误时,可视化可以帮助我们快速定位问题所在。比如,如果我们发现某个卷积层的特征图没有有效地提取到关键特征,或者某些过滤器没有学习到预期的视觉模式,那么就可以针对性地调整模型结构、参数或训练方法,以改善模型的性能。

此外,可视化对于优化模型结构也具有重要的指导意义。通过观察不同结构的卷积神经网络在可视化结果上的差异,我们可以比较不同模型的优缺点,从而选择更合适的模型结构。同时,可视化还可以帮助我们探索新的模型结构和改进方法,为模型的创新和优化提供思路。

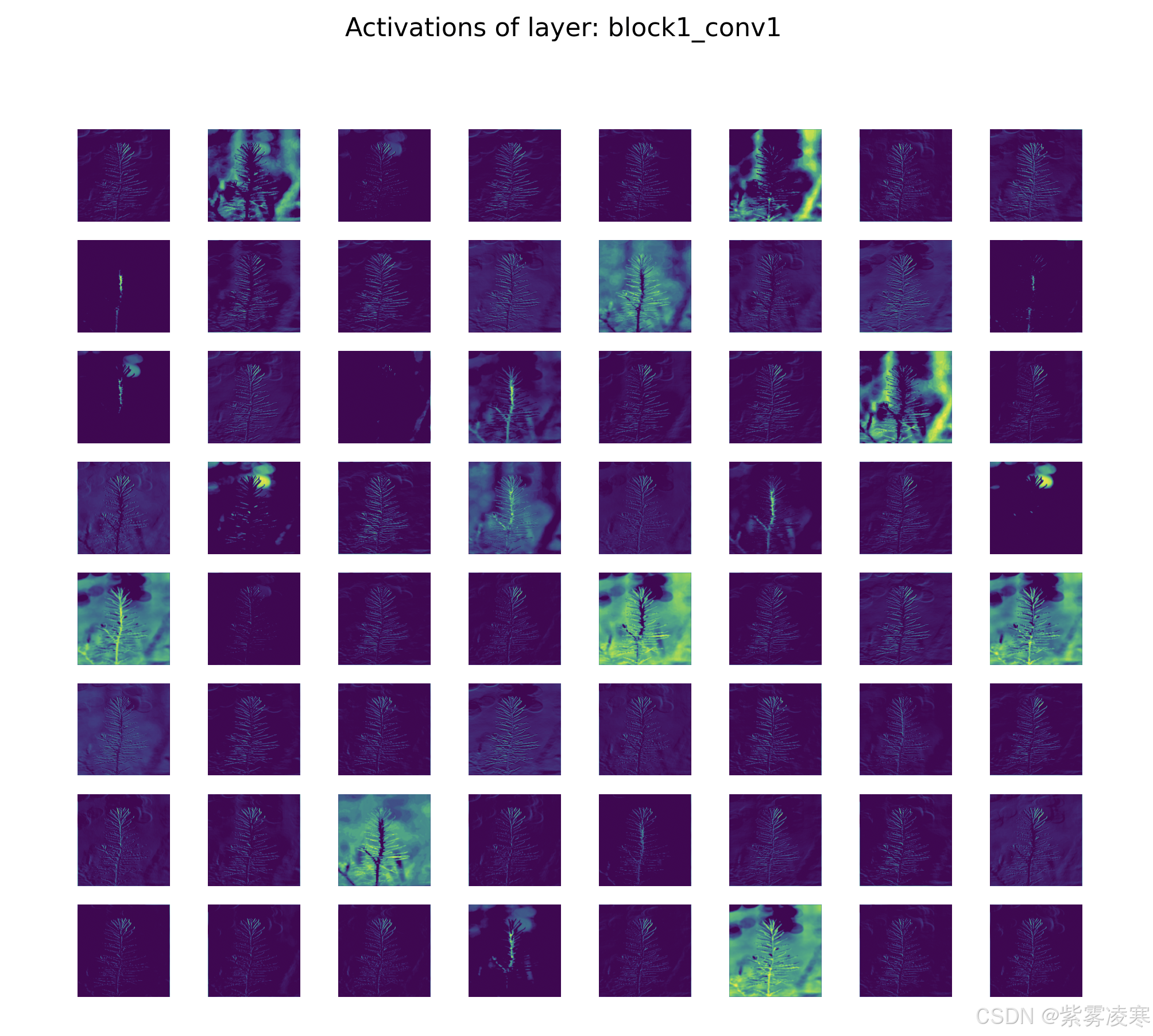

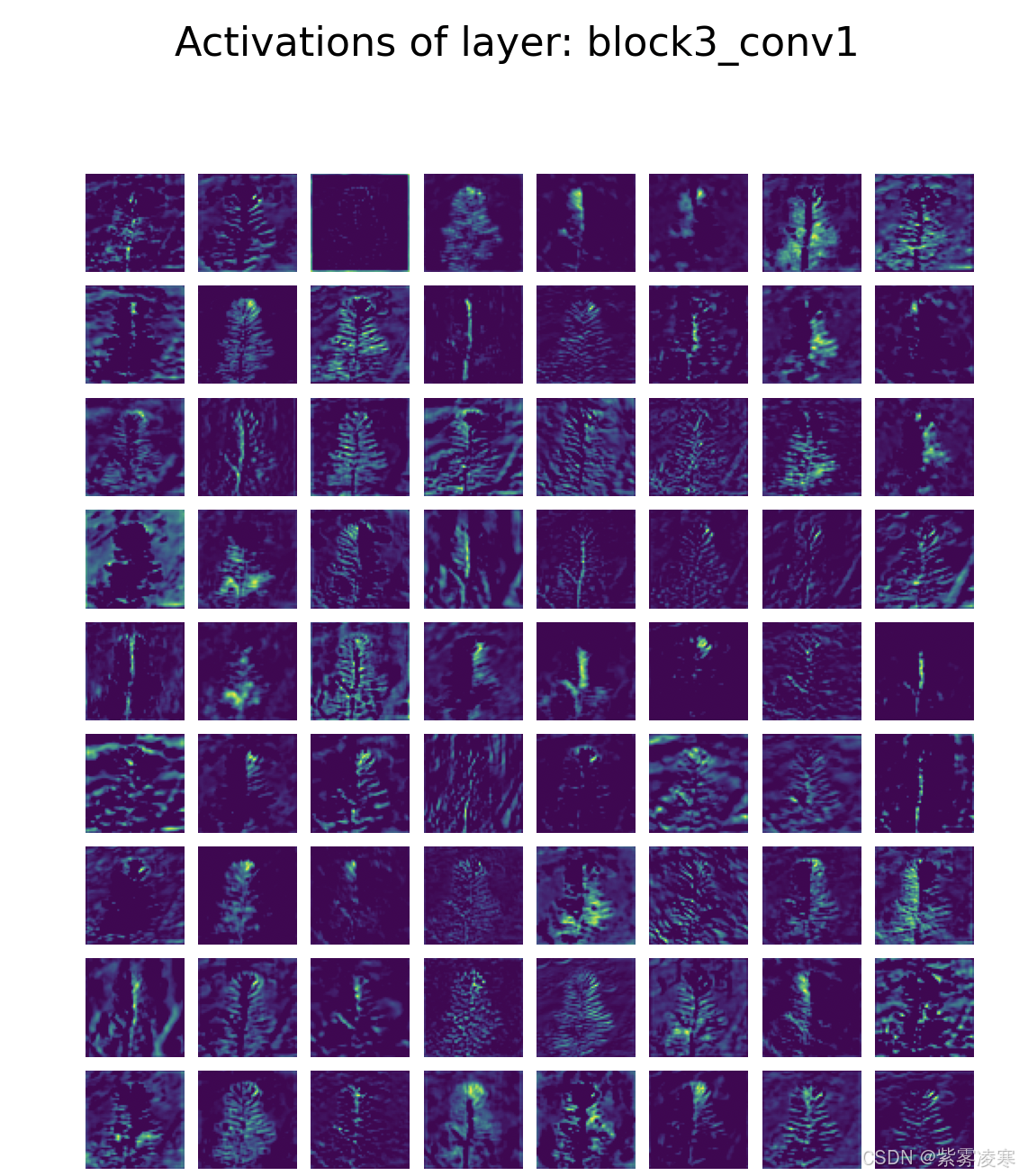

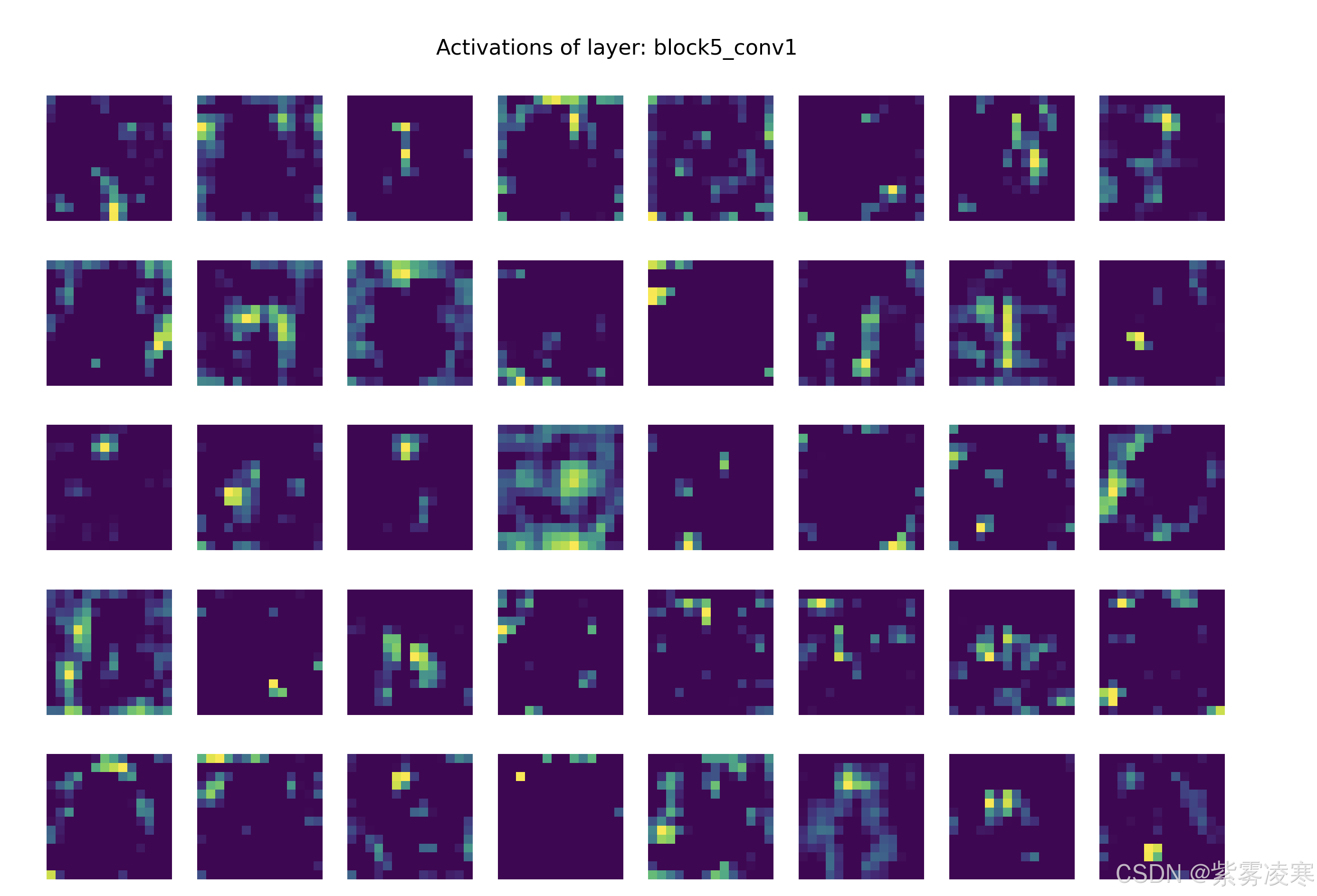

(二)可视化卷积神经网络的中间输出(中间激活)

可视化卷积神经网络的中间输出,即中间激活,能够帮助我们清晰地看到输入图像在网络各层中的变换过程,以及每个过滤器对输入图像的作用效果。

在 Python 中,我们可以借助 Keras 和 TensorFlow 库,轻松实现这一可视化过程。

以下是一个示例代码,展示了如何可视化CNN各个层的中间激活图。假设你已经有一个训练好的CNN模型,或者我们可以用一个简单的预训练模型来进行示范。我们将用 VGG16 作为示例模型,并展示如何获取中间层的输出。

import numpy as np

import matplotlib.pyplot as plt

from tensorflow.keras.models import Model

from tensorflow.keras.applications import VGG16

from tensorflow.keras.preprocessing import image

from tensorflow.keras.applications.vgg16 import preprocess_input

# 加载预训练的VGG16模型

base_model = VGG16(weights='imagenet')

# 打印模型架构,查看所有层的名称

base_model.summary()

# 选择一些中间层,例如‘block1_conv1’, ‘block2_conv1’, 等等

layer_names = ['block1_conv1', 'block2_conv1', 'block3_conv1', 'block4_conv1', 'block5_conv1']

# 创建一个新的模型,用于获取中间层的输出

layer_outputs = [base_model.get_layer(name).output for name in layer_names]

activation_model = Model(inputs=base_model.input, outputs=layer_outputs)

# 加载输入图像并预处理

img_path = 'your_image.jpg' # 替换为你的图片路径

img = image.load_img(img_path, target_size=(224, 224)) # VGG16的输入尺寸是224x224

img_array = image.img_to_array(img)

img_array = np.expand_dims(img_array, axis=0)

img_array = preprocess_input(img_array) # VGG16的预处理方式

# 获取中间层的激活图

activations = activation_model.predict(img_array)

# 可视化中间层的激活图

for layer_name, activation in zip(layer_names, activations):

num_filters = activation.shape[-1] # 获取过滤器的数量

size = activation.shape[1] # 激活图的大小(例如:224x224)

# 设定绘制特征图的网格大小

n_columns = 8 # 每行显示的过滤器数量

n_rows = num_filters // n_columns # 根据过滤器数量计算行数

# 创建绘图窗口

fig, axes = plt.subplots(n_rows, n_columns, figsize=(n_columns * 2, n_rows * 2))

fig.suptitle(f'Activations of layer: {layer_name}', size=16)

# 遍历过滤器并绘制它们的激活图

for i in range(num_filters):

ax = axes[i // n_columns, i % n_columns]

ax.imshow(activation[0, :, :, i], cmap='viridis') # 每个过滤器的激活图

ax.axis('off')

plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

注意事项:

- 你可以更改

layer_names来选择你想要查看的任何中间层。 - 你也可以调整

n_columns来更改每行显示的过滤器数量,确保视觉效果清晰。 - 输入图像的大小和预处理方式可能会因模型而异,VGG16 要求输入大小为

224x224并进行预处理。

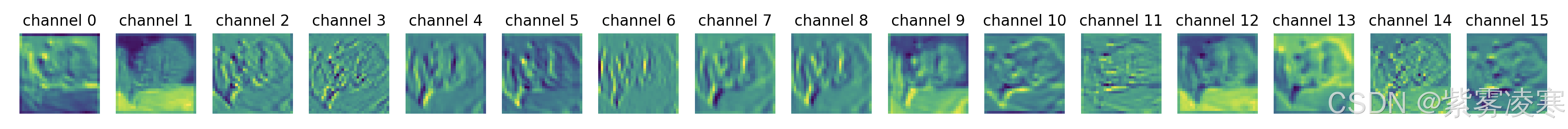

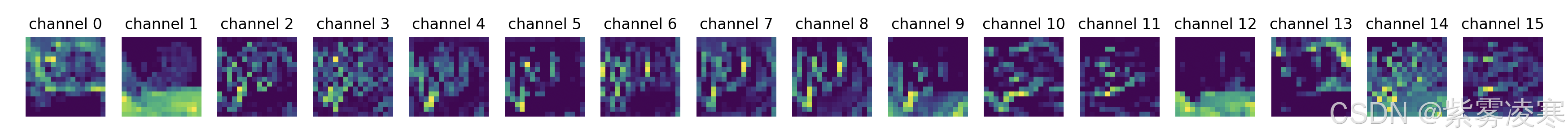

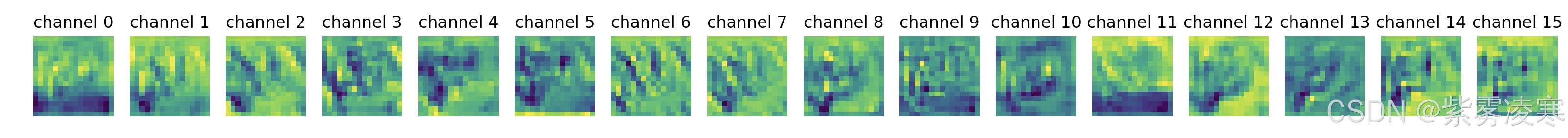

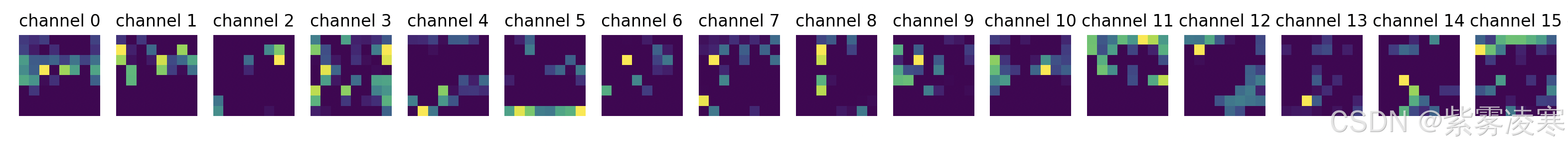

通过上述代码生成的可视化结果,我们可以发现,随着网络层数的增加,特征图逐渐变得更加抽象。在底层卷积层,特征图主要呈现出简单的边缘、线条和颜色等低级特征;而在高层卷积层,特征图则开始出现一些更复杂的形状和模式,这些特征与图像中的物体结构和语义信息更加相关。例如,在中间层可能会出现一些类似于纹理、局部物体部件的特征,而在较深的层中,特征图可能会呈现出与整个物体形状相关的特征。

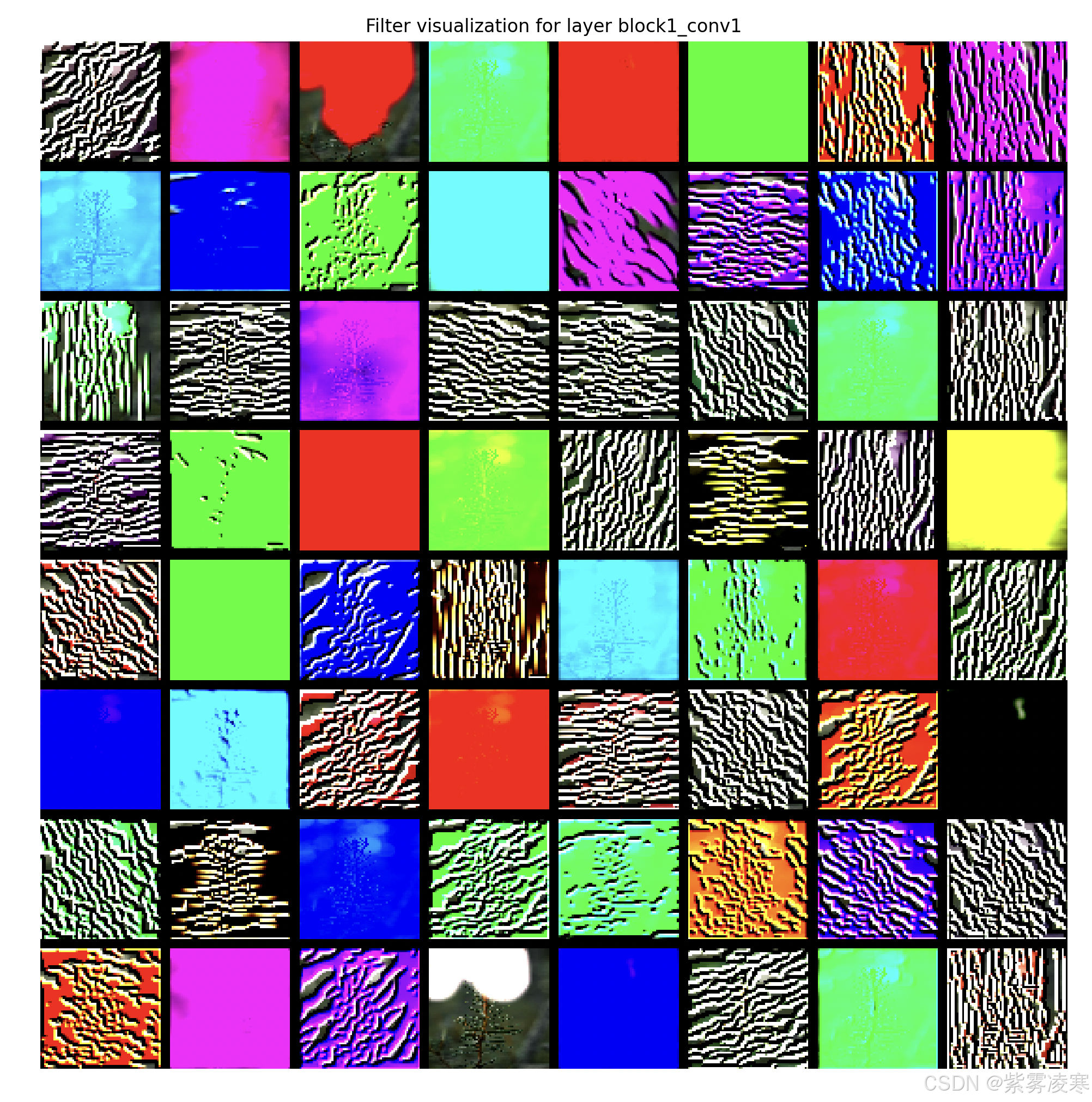

(三)可视化卷积神经网络的过滤器

可视化卷积神经网络的过滤器,可以让我们深入了解每个过滤器所学习到的视觉模式或概念,从而进一步理解卷积神经网络是如何对图像进行特征提取的。

一种常用的可视化过滤器的方法是,通过优化输入图像,使得某个过滤器的响应最大化。我们可以按照以下步骤实现:

- 首先,加载预训练的卷积神经网络模型,这里以 VGG16 模型为例:

import numpy as np

import matplotlib.pyplot as plt

import tensorflow as tf

from tensorflow.keras.applications import VGG16

from tensorflow.keras.preprocessing.image import load_img, img_to_array

# 加载 VGG16 模型

model = VGG16(weights='imagenet', include_top=False)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 然后,定义一个函数来生成能够最大化特定过滤器响应的输入图像:

def generate_pattern(image_path, layer_name, filter_index, size=150, iterations=40, step=1.0):

# 加载并预处理输入图像

input_img_data = load_and_preprocess_image(image_path, size)

input_img_data = tf.convert_to_tensor(input_img_data, dtype=tf.float32)

# 获取指定层的输出

layer_output = model.get_layer(layer_name).output

submodel = tf.keras.Model(inputs=model.input, outputs=layer_output)

# 定义迭代函数

@tf.function

def iterate(img):

with tf.GradientTape() as tape:

tape.watch(img)

layer_output_values = submodel(img)

loss = tf.reduce_mean(layer_output_values[:, :, :, filter_index])

grads = tape.gradient(loss, img)

grads = grads / (tf.sqrt(tf.reduce_mean(tf.square(grads))) + 1e-5)

return loss, grads

# 调试信息

print(f"Generating pattern for filter {filter_index} in layer {layer_name}")

initial_loss, initial_grads = iterate(input_img_data)

print(f"Initial loss: {initial_loss.numpy()}, Initial grads norm: {tf.norm(initial_grads).numpy()}")

# 梯度上升迭代

for i in range(iterations):

loss_value, grads_value = iterate(input_img_data)

input_img_data = input_img_data + grads_value * step

if i % 10 == 0: # 每 10 次迭代打印一次损失值

print(f"Iteration {i}, Loss: {loss_value.numpy()}")

img = input_img_data[0].numpy()

return deprocess_image(img)

def deprocess_image(x):

# 反向预处理(还原 VGG16 预处理)

x = x.copy()

x[:, :, 0] += 103.939

x[:, :, 1] += 116.779

x[:, :, 2] += 123.68

x = x[:, :, ::-1] # BGR 转 RGB

# 剪裁到 [0, 255]

x = np.clip(x, 0, 255).astype('uint8')

return x

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 接下来,我们可以生成某一层中所有过滤器响应模式组成的网格,以便更直观地观察不同过滤器的特征:

def load_and_preprocess_image(image_path, size):

# 加载指定图像并调整大小

img = load_img(image_path, target_size=(size, size))

img = img_to_array(img)

# 添加批量维度

img = np.expand_dims(img, axis=0)

# 归一化到 [-1, 1] 范围(VGG16 的预处理方式)

img = tf.keras.applications.vgg16.preprocess_input(img)

return img

# 设置参数

image_path = './resource/image.jpg' # 替换为你的图像路径

layer_name = 'block1_conv1'

size = 64

margin = 5

iterations = 100 # 增加迭代次数

step = 5.0 # 增大步长

# 初始化结果数组

results = np.zeros((8 * size + 7 * margin, 8 * size + 7 * margin, 3), dtype=np.uint8)

# 生成滤波器可视化图案

for i in range(8):

for j in range(8):

filter_img = generate_pattern(image_path, layer_name, i + (j * 8), size=size, iterations=iterations, step=step)

horizontal_start = i * size + i * margin

horizontal_end = horizontal_start + size

vertical_start = j * size + j * margin

vertical_end = vertical_start + size

results[horizontal_start:horizontal_end, vertical_start:vertical_end, :] = filter_img

# 显示结果

plt.figure(figsize=(20, 20))

plt.imshow(results)

plt.axis('off')

plt.title(f'Filter visualization for layer {layer_name}')

plt.show()

# 保存结果(可选)

plt.imsave('filter_visualization.png', results)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

通过上述代码生成的可视化结果,我们可以看到不同层的过滤器学习到的特征具有明显的差异。在第一层(如 block1_conv1 ),过滤器主要学习到简单的方向边缘和颜色特征,例如有的过滤器对水平边缘敏感,有的对垂直边缘敏感,还有的对特定颜色的区域敏感。随着网络层数的增加,过滤器学习到的特征逐渐变得更加复杂。在第二层,过滤器开始学习到由边缘和颜色组合而成的简单纹理。而在更高层,过滤器学习到的特征类似于自然图像中的更复杂的纹理,如羽毛、眼睛、树叶等。这些结果表明,卷积神经网络的过滤器能够从低级的视觉特征逐步学习到更高级、更抽象的语义特征,从而实现对图像的有效理解和分类。

(四)可视化图像中类激活的热力图

类激活热力图(Class Activation Map,简称 CAM)是一种非常有用的可视化工具,它能够帮助我们理解图像中哪些区域对模型的分类决策起到了关键作用,从而定位图像中被识别为某类别的区域。

类激活热力图的原理基于全局平均池化(Global Average Pooling,GAP)和权重计算。在卷积神经网络的最后一个卷积层之后,通过全局平均池化将每个特征图压缩为一个单一的值,这些值代表了每个特征图在整个图像上的平均激活程度。然后,将这些值与全连接层的权重进行加权求和,得到每个类别的激活分数。对于特定的类别,我们可以根据这些权重和特征图的值计算出类激活热力图,其中热力图上的每个像素点表示该位置对该类别的激活程度,颜色越鲜艳表示激活程度越高,即该区域对分类结果的影响越大。

以使用 Keras 和 VGG16 模型生成类激活热力图为例,实现步骤如下:

import numpy as np

import tensorflow as tf

from tensorflow.keras.applications.vgg16 import VGG16, preprocess_input

from tensorflow.keras.preprocessing import image

import cv2

import matplotlib.pyplot as plt

# 加载 VGG16 模型

model = VGG16(weights='imagenet')

# 图像路径

img_path = './resource/image.jpg'

# 加载并预处理图像

img = image.load_img(img_path, target_size=(224, 224))

x = image.img_to_array(img)

x = np.expand_dims(x, axis=0)

x = preprocess_input(x)

x = tf.convert_to_tensor(x, dtype=tf.float32)

# 预测类别

preds = model.predict(x)

predicted_class = np.argmax(preds[0])

print(f"Predicted class index: {predicted_class}")

# 获取最后一层卷积层

last_conv_layer = model.get_layer('block5_conv3')

# 使用 GradientTape 计算梯度

def get_heatmap(input_img):

with tf.GradientTape() as tape:

tape.watch(input_img)

conv_outputs = last_conv_layer.output

submodel = tf.keras.Model(inputs=model.input, outputs=[conv_outputs, model.output])

conv_outputs, outputs = submodel(input_img)

loss = outputs[:, predicted_class]

grads = tape.gradient(loss, conv_outputs)

if grads is None:

raise ValueError("Gradient computation failed, returned None")

pooled_grads = tf.reduce_mean(grads, axis=(0, 1, 2))

conv_outputs = conv_outputs[0]

heatmap = tf.reduce_mean(conv_outputs * pooled_grads, axis=-1)

heatmap = tf.maximum(heatmap, 0)

heatmap = heatmap / tf.reduce_max(heatmap)

return heatmap.numpy()

# 生成热力图

heatmap = get_heatmap(x)

# 调整热力图大小并可视化

img = cv2.imread(img_path)

heatmap = cv2.resize(heatmap, (img.shape[1], img.shape[0]))

heatmap = np.uint8(255 * heatmap)

heatmap = cv2.applyColorMap(heatmap, cv2.COLORMAP_JET)

# 叠加热力图到原图,并确保结果是 uint8 类型

superimposed_img = heatmap * 0.4 + img

superimposed_img = np.clip(superimposed_img, 0, 255).astype(np.uint8) # 转换为 uint8

# 保存并显示结果

cv2.imwrite('elephant_cam.jpg', superimposed_img)

plt.imshow(cv2.cvtColor(superimposed_img, cv2.COLOR_BGR2RGB))

plt.title('Class Activation Map')

plt.axis('off')

plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

通过上述代码生成的类激活热力图,我们可以清晰地看到,在识别植物的图像中,热力图主要集中在植物的中间躯干关键部位,这表明模型在做出分类决策时,主要依据这些区域的特征。而图像中的背景部分,热力图的激活程度较低,说明它们对分类结果的影响较小。这种可视化方法不仅有助于我们理解模型的决策依据,还可以用于评估模型的性能和准确性,以及发现模型可能存在的错误和偏差。

四、实战演练

(一)准备数据集

在本次实战中,我们选择 CIFAR-10 数据集,它是一个广泛应用于图像分类任务的经典数据集。CIFAR-10 数据集包含 60000 张 32x32 像素的彩色图像,这些图像分为 10 个不同的类别,每个类别有 6000 张图片,具体类别包括飞机、汽车、鸟类、猫、鹿、狗、青蛙、马、船和卡车。数据集被划分为 50000 张训练图像和 10000 张测试图像 。

使用 Python 的 torchvision 库来加载和预处理 CIFAR-10 数据集,代码如下:

import torchvision

import torchvision.transforms as transforms

# 数据预处理,将图像转换为张量并归一化

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))

])

# 加载训练集和测试集

trainset = torchvision.datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=32, shuffle=True, num_workers=2)

testset = torchvision.datasets.CIFAR10(root='./data', train=False, download=True, transform=transform)

testloader = torch.utils.data.DataLoader(testset, batch_size=32, shuffle=False, num_workers=2)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

在上述代码中:

transforms.ToTensor()将 PIL 图像转换为 PyTorch 张量,transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))对图像进行归一化处理,将像素值从 0 - 255 映射到 - 1 - 1,这样可以加速模型的收敛。DataLoader用于将数据集整理成批次,便于模型训练和测试。

(二)构建卷积神经网络模型

我们使用 PyTorch 来构建一个简单的卷积神经网络模型,代码如下:

import torch

import torch.nn as nn

import torch.nn.functional as F

# 定义模型

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(3, 16, 3, padding=1)

self.pool1 = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(16, 32, 3, padding=1)

self.pool2 = nn.MaxPool2d(2, 2)

self.flatten = nn.Flatten()

self.fc1 = nn.Linear(32 * 8 * 8, 128)

self.fc2 = nn.Linear(128, 10)

def forward(self, x):

x = self.pool1(F.relu(self.conv1(x)))

x = self.pool2(F.relu(self.conv2(x)))

x = self.flatten(x)

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

在这个模型中:

conv1和conv2是卷积层,用于提取图像的特征。pool1和pool2是最大池化层,用于降低特征图的维度,减少计算量。flatten层将多维的特征图展平为一维向量,以便输入到全连接层。fc1和fc2是全连接层,用于对提取到的特征进行分类。

(三)训练模型

定义损失函数和优化器,并进行模型训练,代码如下:

import torch.optim as optim

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(net.parameters(), lr=0.001)

# 训练模型

for epoch in range(10):

running_loss = 0.0

for i, data in enumerate(trainloader, 0):

inputs, labels = data

optimizer.zero_grad()

outputs = net(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

if i % 100 == 99:

print(f'Epoch {epoch + 1}, Step {i + 1}, Loss: {running_loss / 100:.3f}')

running_loss = 0.0

print('Finished Training')

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

在训练过程中,我们使用交叉熵损失函数 CrossEntropyLoss 来衡量模型预测与真实标签之间的差异,优化器选择 Adam,学习率设置为 0.001。在每个 epoch 中,遍历训练数据加载器,对每个批次的数据进行前向传播、计算损失、反向传播和参数更新。每 100 个步骤打印一次训练损失,以便监控训练过程。

(四)模型评估与可视化分析

训练完成后,对模型在测试集上进行评估,并利用前面介绍的可视化方法对模型进行分析。

# 测试模型

correct = 0

total = 0

with torch.no_grad():

for data in testloader:

images, labels = data

outputs = net(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f'Accuracy of the network on the 10000 test images: {100 * correct / total}%')

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

在上述代码中,通过遍历测试数据加载器,计算模型在测试集上的预测准确率。

接下来进行可视化分析,以可视化中间激活为例:

import matplotlib.pyplot as plt

from torchvision.utils import make_grid

# 可视化中间层激活

# 选择一张测试图像

image, label = next(iter(testloader))

image = image[0].unsqueeze(0)

# 注册钩子函数,用于获取中间层的输出

activations = []

def hook(module, input, output):

activations.append(output)

net.conv1.register_forward_hook(hook)

net.pool1.register_forward_hook(hook)

net.conv2.register_forward_hook(hook)

net.pool2.register_forward_hook(hook)

# 前向传播

_ = net(image)

# 可视化中间激活

layer_names = ['conv1', 'pool1', 'conv2', 'pool2']

for i, activation in enumerate(activations):

activation = activation.squeeze(0).cpu().detach()

num_channels = activation.size(0)

fig, axes = plt.subplots(1, num_channels, figsize=(num_channels * 3, 3))

for j in range(num_channels):

axes[j].imshow(activation[j], cmap='viridis')

axes[j].axis('off')

axes[j].set_title(f'{layer_names[i]} channel {j}')

plt.imsave('filter_visualization.png', axes)

plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- conv1:

- pool1

- conv2

- pool2

上述代码中,通过注册钩子函数获取模型中间层的输出,并对这些输出进行可视化。以 conv1、pool1、conv2 和 pool2 层为例,展示了每个层不同通道的激活情况,帮助我们直观地了解图像在模型中的特征提取过程。从可视化结果可以看出,随着网络层的加深,特征图逐渐从简单的边缘、纹理等低级特征向更复杂、更抽象的特征转变,这与我们之前对卷积神经网络原理的理解是一致的 。

五、总结与展望

(一)总结

卷积神经网络作为深度学习领域的重要模型,凭借其独特的结构和强大的特征提取能力,在计算机视觉等众多领域取得了令人瞩目的成就。通过深入探究其数学原理,我们理解了从图像的数据结构,到卷积运算、池化操作、激活函数等各个环节的工作机制,这些原理是卷积神经网络能够有效学习和处理图像数据的基石。

同时,可视化方法为我们洞察卷积神经网络的内部工作机制提供了有力的工具。通过可视化中间输出、过滤器和类激活热力图,我们能够直观地看到图像在网络中的特征提取过程、过滤器所学习到的特征模式以及模型做出分类决策的依据,这不仅有助于我们更好地理解模型,还能为模型的优化和改进提供指导。

在实战演练中,我们通过构建和训练一个简单的卷积神经网络模型,将理论知识应用到实际项目中,进一步加深了对卷积神经网络的理解和掌握。从数据集的准备、模型的构建,到模型的训练和评估,每个步骤都涉及到数学原理和实际操作的结合,而可视化分析则为我们评估模型性能和理解模型行为提供了直观的方式。

(二)展望

随着技术的不断发展,卷积神经网络在未来有望取得更大的突破和应用拓展。在模型结构方面,研究人员将继续探索更加高效、强大的网络架构,以进一步提高模型的性能和泛化能力。例如,可能会出现更加复杂的卷积核设计、更合理的网络层次结构以及更有效的参数共享策略,从而使模型能够更好地处理各种复杂的任务。

在应用领域,卷积神经网络将在医疗、交通、金融等更多领域发挥重要作用。在医疗领域,它可以帮助医生更准确地诊断疾病,如通过分析医学影像来检测肿瘤、病变等;在交通领域,它将助力自动驾驶技术的发展,实现更安全、高效的交通出行;在金融领域,它可以用于风险评估、欺诈检测等任务。

此外,随着人工智能技术的不断融合,卷积神经网络可能会与其他技术如强化学习、生成对抗网络等相结合,创造出更具创新性的应用和解决方案。例如,将卷积神经网络与强化学习相结合,可以实现智能机器人的自主决策和控制;将卷积神经网络与生成对抗网络相结合,可以生成更加逼真的图像、视频等内容。

卷积神经网络作为人工智能领域的核心技术之一,具有广阔的发展前景和无限的潜力。

延伸阅读

-

计算机视觉系列文章

计算机视觉基础|从 OpenCV 到频域分析 -

机器学习核心算法系列文章

解锁机器学习核心算法|神经网络:AI 领域的 “超级引擎”

解锁机器学习核心算法|主成分分析(PCA):降维的魔法棒

解锁机器学习核心算法|朴素贝叶斯:分类的智慧法则

解锁机器学习核心算法 | 支持向量机算法:机器学习中的分类利刃

解锁机器学习核心算法 | 随机森林算法:机器学习的超强武器

解锁机器学习核心算法 | K -近邻算法:机器学习的神奇钥匙

解锁机器学习核心算法 | K-平均:揭开K-平均算法的神秘面纱

解锁机器学习核心算法 | 决策树:机器学习中高效分类的利器

解锁机器学习核心算法 | 逻辑回归:不是回归的“回归”

解锁机器学习核心算法 | 线性回归:机器学习的基石

-

深度学习框架探系列文章

深度学习框架探秘|TensorFlow:AI 世界的万能钥匙

深度学习框架探秘|PyTorch:AI 开发的灵动画笔

深度学习框架探秘|TensorFlow vs PyTorch:AI 框架的巅峰对决

深度学习框架探秘|Keras:深度学习的魔法钥匙

评论记录:

回复评论: